Bias in der KI: Wie Vorurteile in Algorithmen entstehen

KI-Bias - Wie Vorurteile in Algorithmen entstehen. Entdecken Sie, wie Voreingenommenheit in KI zu verzerrten Ergebnissen führt. Ursachen: Verzerrte Trainingsdaten.

Hast du dich jemals gefragt, warum KI-Systeme manchmal unfair erscheinen? Bias Künstliche Intelligenz entsteht oft, weil die Daten, mit denen sie trainiert werden, nicht neutral sind. Ein Beispiel: Eine Studie des MIT Media Lab zeigte, dass Gesichtserkennungssysteme bei dunkelhäutigen Frauen Fehlerquoten von bis zu 34,7 % hatten, während sie bei hellhäutigen Männern fast immer korrekt arbeiteten. Das Problem liegt in den verzerrten Trainingsdaten. Solche Ungerechtigkeiten beeinflussen Entscheidungen in wichtigen Bereichen wie Gesundheitsversorgung oder Personalrekrutierung. Das zeigt, wie entscheidend es ist, Bias Künstliche Intelligenz zu verstehen und zu bekämpfen.

Wichtige Erkenntnisse

Bias in KI passiert oft durch falsche oder wenige Daten. Nutze Daten, die verschieden sind.

Menschen bringen oft unbewusst ihre Vorurteile in Algorithmen ein. Entwickler sollten ihre eigenen Vorurteile kennen.

Verschiedene Menschen in Teams sind wichtig. Verschiedene Meinungen helfen, Bias zu finden und zu stoppen.

Wenn KI-Systeme nicht klar sind, ist Bias schwer zu sehen. Systeme sollten leicht zu verstehen sein, um Vertrauen zu schaffen.

Regelmäßige Prüfungen von KI-Systemen zeigen Fehler. Experten von außen können gute Tipps geben.

Lernen über KI und ihre Probleme ist wichtig. Informiere dich und andere, um besser Bescheid zu wissen.

Regeln und Gesetze für KI sind nötig. Gesetze wie der 'AI Act' der EU können helfen, Bias zu verringern.

Jeder kann helfen, Bias und Verzerrung beim Einsatz von KI-Anwendungen zu reduzieren. Stelle Fragen, verlange Klarheit und unterstütze faire Technik.

Was bedeutet Bias in der Künstlichen Intelligenz?

Definition und Konzept von Bias

Bias in der Künstlichen Intelligenz beschreibt systematische Verzerrungen, die zu unfairen oder diskriminierenden Entscheidungen führen können. Aber warum passiert das? Oft liegt es an den Daten, die ein KI-System trainieren, oder an den Entscheidungen, die Entwickler während der Modellierung treffen. Zum Beispiel können ungenaue oder einseitige Daten dazu führen, dass ein Algorithmus bestimmte Gruppen bevorzugt oder benachteiligt.

Hier sind einige grundlegende Konzepte, die Bias in KI erklären:

Ein bekanntes Beispiel: Ein KI-Modell, das Panzer von anderen Fahrzeugen unterscheiden sollte, wurde nur mit Tageslichtbildern trainiert. Es scheiterte bei Nachtaufnahmen. Das zeigt, wie wichtig die Qualität und Vielfalt der Daten ist.

Arten von Bias in KI-Systemen

Bias Künstliche Intelligenz kann auf verschiedene Arten auftreten. Lass uns die drei häufigsten Typen anschauen:

Datenbasierter Bias

Dieser Bias entsteht, wenn die Trainingsdaten unvollständig oder verzerrt sind. Stell dir vor, ein KI-System für Gesichtserkennung wird mit Bildern trainiert, die hauptsächlich von hellhäutigen Personen stammen. Das Ergebnis? Es erkennt dunkelhäutige Gesichter weniger genau. Solche Verzerrungen spiegeln oft bestehende gesellschaftliche Ungleichheiten wider.

Algorithmischer Bias

Hier geht es um die Art und Weise, wie Algorithmen programmiert werden. Entwickler treffen Entscheidungen, welche Merkmale wichtig sind und wie sie gewichtet werden. Diese Entscheidungen können unbewusst Vorurteile einführen. Zum Beispiel kann die Auswahl bestimmter Merkmale wie Wohnort oder Einkommen zu diskriminierenden Ergebnissen führen.

Bias durch Interaktion

Dieser Bias tritt auf, wenn Nutzer mit einem KI-System interagieren. Ein Beispiel ist ein Chatbot, der durch Benutzereingaben lernt. Wenn Nutzer rassistische oder sexistische Inhalte eingeben, kann der Chatbot diese Vorurteile übernehmen und verstärken.

Warum Bias in der KI problematisch ist

Bias in der Künstlichen Intelligenz ist nicht nur ein technisches Problem. Es hat reale Auswirkungen auf Menschen. Stell dir vor, ein KI-System entscheidet, wer für einen Kredit genehmigt wird. Wenn das System voreingenommen ist, könnten bestimmte Gruppen systematisch benachteiligt werden. Das verstärkt bestehende Ungleichheiten und schafft neue Barrieren.

Ein weiteres Problem ist die fehlende Transparenz. Oft ist es schwer zu verstehen, warum ein KI-System eine bestimmte Entscheidung getroffen hat. Das macht es schwierig, Bias zu erkennen und zu beheben. Und das ist gefährlich, besonders in sensiblen Bereichen wie Justiz oder Gesundheitswesen.

Wie entsteht Bias in Algorithmen?

Hast du dich jemals gefragt, warum Algorithmen manchmal Entscheidungen treffen, die unfair erscheinen? Bias in Algorithmen entsteht nicht zufällig. Es gibt klare Gründe, warum diese Verzerrungen auftreten, und sie beginnen oft schon bei der Entwicklung der Systeme. Lass uns genauer hinschauen.

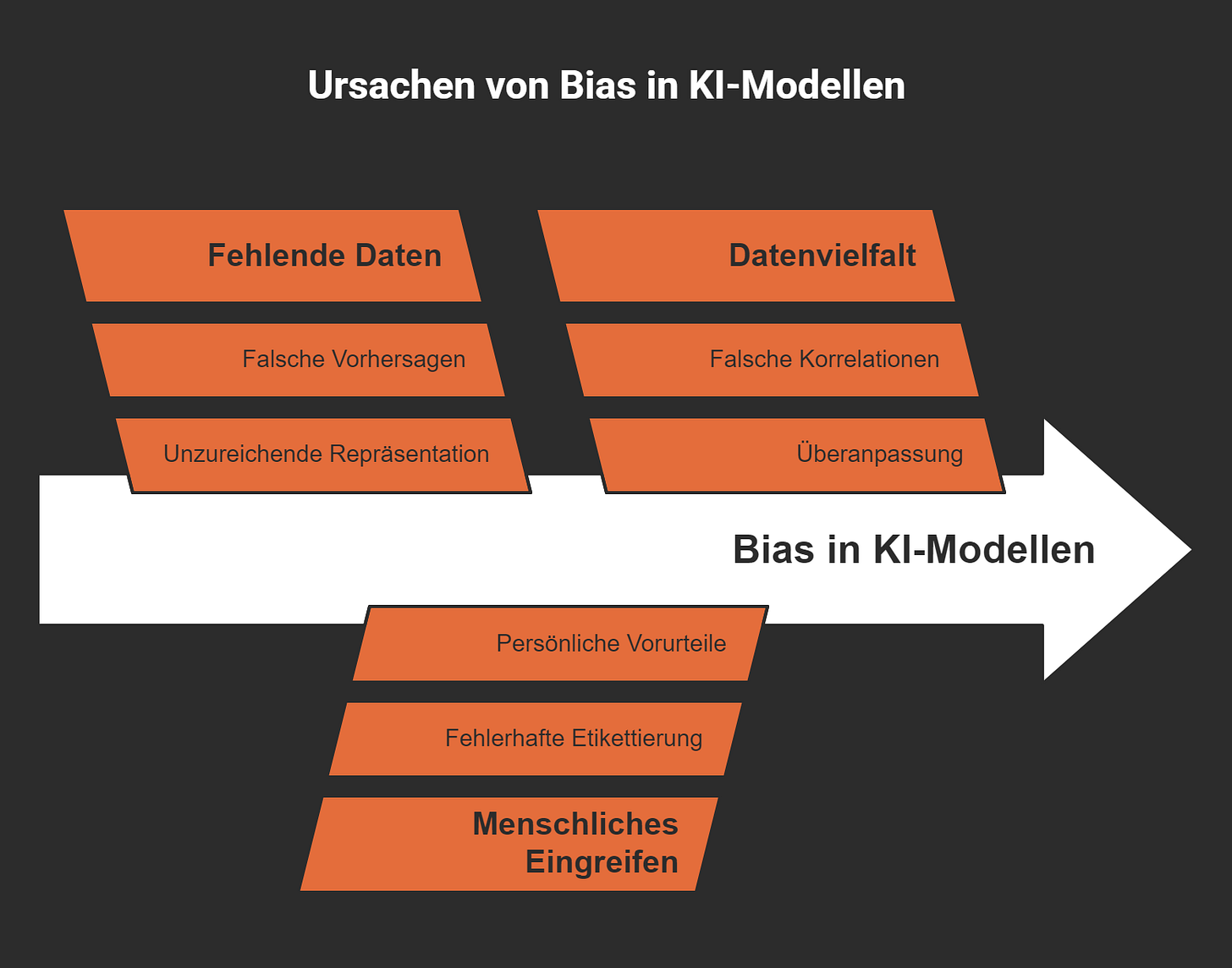

Verzerrte oder unvollständige Trainingsdaten

Die Qualität der Daten, mit denen ein KI-System trainiert wird, ist entscheidend. Wenn die Daten verzerrt oder unvollständig sind, spiegelt das System diese Fehler wider. Stell dir vor, du trainierst eine Gesichtserkennungssoftware nur mit Bildern von hellhäutigen Personen. Was passiert? Das System erkennt dunkelhäutige Gesichter weniger genau. Genau das ist in der Vergangenheit passiert. Solche Verzerrungen entstehen, weil die Trainingsdaten nicht die Vielfalt der realen Welt abbilden.

Einige Studien zeigen, wie fehlerhafte Daten Bias Künstliche Intelligenz verursachen können:

Diskriminierung kann bereits während des Trainingsprozesses entstehen, wenn gesellschaftliche Vorurteile in die Daten einfließen.

Veraltete oder unvollständige Datensätze führen zu falschen Ergebnissen und diskriminierenden Entscheidungen.

Ein Beispiel: Ein Chatbot, der mit fremdenfeindlichen Inhalten gefüttert wird, übernimmt diese Vorurteile und verstärkt sie.

Unvollständige Daten sind wie ein Puzzle mit fehlenden Teilen. Sie verzerren die Sichtweise des Algorithmus und führen zu falschen Schlussfolgerungen. Kontrollierte Experimente haben gezeigt, dass Algorithmen, die auf solchen Datensätzen basieren, diese Verzerrungen in ihren Entscheidungen weitergeben.

Einfluss menschlicher Vorurteile

Algorithmen sind nicht neutral. Sie werden von Menschen entwickelt, und Menschen haben Vorurteile – bewusst oder unbewusst. Diese Vorurteile können sich in den Entscheidungen widerspiegeln, die Entwickler während der Modellierung treffen. Zum Beispiel: Welche Daten werden ausgewählt, um Verzerrung beim KI-Modell zu vermeiden? Welche Merkmale werden als wichtig betrachtet? Solche Entscheidungen können Bias Künstliche Intelligenz verstärken.

Empirische Untersuchungen zeigen, dass menschliche Vorurteile oft unbewusst in Algorithmen einfließen:

KI-Modelle, die mit subjektiver Sprache aus sozialen Medien trainiert werden, übernehmen oft geschlechtsspezifische oder ethnische Vorurteile.

Frauen werden in solchen Modellen häufiger mit häuslichen Begriffen assoziiert, während Männer mit beruflichen Kontexten verbunden werden.

Das Problem liegt nicht nur in den Daten, sondern auch in der Art und Weise, wie Entwickler Algorithmen gestalten. Wenn diese Vorurteile nicht erkannt und korrigiert werden, können sie zu diskriminierenden Ergebnissen führen.

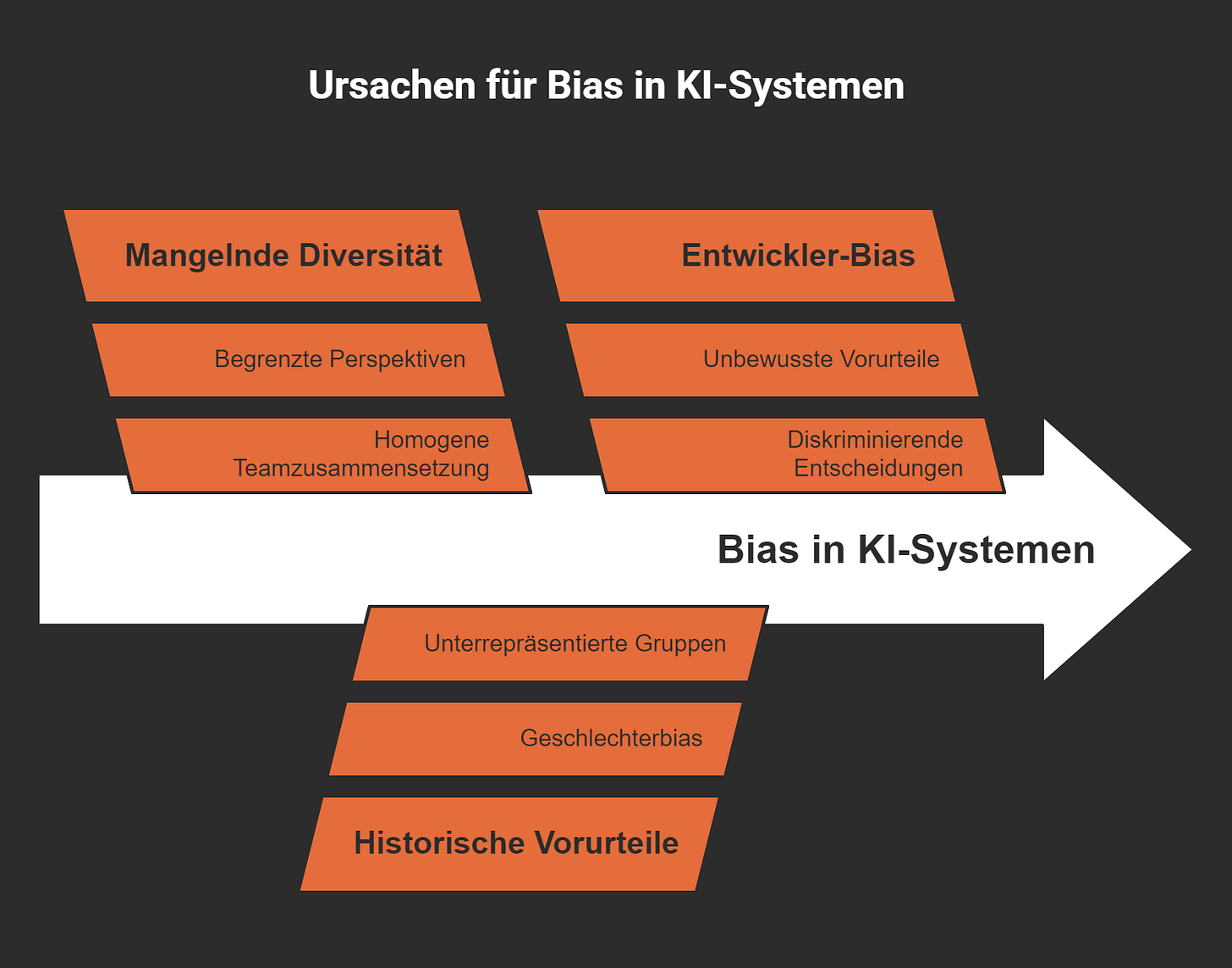

Mangel an Diversität in Entwicklungsteams

Ein weiterer wichtiger Faktor ist die fehlende Diversität in den Teams, die KI-Systeme entwickeln. Wenn ein Team hauptsächlich aus einer homogenen Gruppe besteht, fehlen oft die Perspektiven, um potenzielle Bias zu erkennen und zu vermeiden. Stell dir vor, ein Team aus einer einzigen kulturellen oder sozialen Gruppe entwickelt ein System. Es ist wahrscheinlich, dass sie unbewusst Annahmen treffen, die andere Gruppen ausschließen.

Studien belegen den Zusammenhang zwischen mangelnder Diversität und Bias:

Ein Beispiel: Die Bertelsmann-Stiftung hat ein Fellowship-Programm ins Leben gerufen, um Diversität in der KI-Entwicklung zu fördern. Solche Initiativen sind entscheidend, um sicherzustellen, dass KI-Systeme fair und inklusiv gestaltet werden und die Verzerrung beim Datensatz minimiert wird.

Denk daran: Bias in Algorithmen entsteht nicht nur durch technische Fehler. Es ist ein Spiegelbild der Gesellschaft, in der wir leben. Um diese Probleme zu lösen, müssen wir die Wurzeln des Bias verstehen und aktiv daran arbeiten, sie zu beseitigen.

Fehlende Transparenz und Nachvollziehbarkeit

Hast du dich jemals gefragt, warum KI-Systeme oft wie eine "Black Box" wirken? Du siehst das Ergebnis, aber der Weg dorthin bleibt ein Rätsel. Genau das ist das Problem mit fehlender Transparenz und Nachvollziehbarkeit in der Künstlichen Intelligenz. Wenn du nicht verstehst, wie ein Algorithmus Entscheidungen trifft, wird es schwierig, Fehler oder Verzerrungen zu erkennen und zu beheben.

Ein großes Hindernis ist die Komplexität moderner Algorithmen. Viele KI-Systeme, besonders solche, die auf maschinellem Lernen basieren, arbeiten mit Millionen von Datenpunkten und mathematischen Modellen. Diese Modelle sind so kompliziert, dass selbst die Entwickler oft nicht genau erklären können, wie eine Entscheidung zustande kommt. Das führt zu einer Situation, in der du den Ergebnissen eines Systems vertrauen sollst, ohne zu wissen, ob sie fair oder korrekt sind.

Wusstest du? Große Unternehmen halten ihre Algorithmen oft geheim. Das bedeutet, dass niemand außerhalb des Unternehmens überprüfen kann, wie Entscheidungen getroffen werden. Diese Intransparenz schafft eine "Black Box"-Situation, die Vertrauen und Fairness untergräbt.

Ein weiteres Problem ist die fehlende Vielfalt in den Trainingsdaten. Wenn die Daten nicht alle Bevölkerungsgruppen repräsentieren, entstehen Verzerrungen. Entscheidungen, die auf solchen Daten basieren, sind oft nicht für alle fair. Zum Beispiel haben Länder mit weniger entwickelten Daten-Ökosystemen, wie viele afrikanische Länder, Schwierigkeiten, eigene KI-Initiativen zu entwickeln. Sie sind auf ausländische Technologien angewiesen, die möglicherweise nicht auf ihre spezifischen Bedürfnisse zugeschnitten sind.

Warum ist das alles so problematisch? Stell dir vor, ein KI-System entscheidet, wer für eine medizinische Behandlung priorisiert wird. Wenn du nicht nachvollziehen kannst, warum das System eine bestimmte Entscheidung getroffen hat, wie kannst du sicher sein, dass es keine Vorurteile gibt? Fehlende Transparenz macht es fast unmöglich, Bias Künstliche Intelligenz zu erkennen und zu korrigieren. Das ist besonders gefährlich in sensiblen Bereichen wie Gesundheitswesen, Justiz oder Personalwesen.

Die Lösung? Entwickler müssen Systeme schaffen, die nicht nur leistungsfähig, sondern auch erklärbar sind. Du solltest in der Lage sein, die Logik hinter einer Entscheidung zu verstehen. Nur so kannst du sicherstellen, dass KI-Systeme fair und gerecht bleiben.

Beispiele für Bias in der Praxis

Diskriminierung in der Personalrekrutierung

Hast du dich jemals gefragt, warum KI-Systeme in der Personalrekrutierung manchmal unfair erscheinen? Der Grund liegt oft in den Daten, die verwendet werden, um diese Systeme zu trainieren. Wenn historische Daten bereits Diskriminierung enthalten, übernimmt die KI diese Muster. Zum Beispiel könnten Bewerbungen von Frauen in technischen Berufen systematisch schlechter bewertet werden, weil frühere Entscheidungen männliche Bewerber bevorzugt haben.

„Der Arbeitsmarkt ist bereits jetzt ein Umfeld, in welchem verschiedene Gruppen diskriminiert und schlechter gestellt werden“, sagt Dürr. Dies zeige sich in den Erwerbsverläufen und Daten der Bewerber. „Wenn diese Daten verwendet werden, um ein algorithmisches System zu trainieren, kann es dazu führen, dass diskriminierende Muster erkannt und verstärkt werden.“

Ein weiteres Problem ist, dass KI oft nur wirtschaftliche Kriterien berücksichtigt. Das führt dazu, dass strukturell benachteiligte Gruppen noch mehr Nachteile erfahren. Stell dir vor, ein Algorithmus bewertet Bewerber basierend auf ihrem Wohnort oder ihrer bisherigen Berufserfahrung. Menschen aus sozial schwächeren Gegenden könnten dadurch automatisch schlechtere Chancen haben.

Gründe für Diskriminierung in der Personalrekrutierung:

Trainingsdaten enthalten bereits Vorurteile.

Das Finetuning der KI wird unbewusst diskriminierend durchgeführt.

Wichtige soziale Faktoren und sensible Merkmale werden nicht berücksichtigt.

Ethnische Vorurteile in der Strafjustiz

Die Strafjustiz ist ein Bereich, in dem Bias Künstliche Intelligenz besonders gefährlich sein kann. Stell dir vor, ein Algorithmus entscheidet, ob jemand auf Bewährung freikommt oder nicht. Wenn die Trainingsdaten zeigen, dass bestimmte ethnische Gruppen häufiger verurteilt wurden, könnte die KI diese Gruppen automatisch als "höheres Risiko" einstufen.

Ein bekanntes Beispiel stammt aus den USA. Dort wurde ein Algorithmus namens COMPAS verwendet, um die Rückfallwahrscheinlichkeit von Straftätern zu bewerten. Studien zeigten, dass das System afroamerikanische Personen häufiger als "hohes Risiko" einstufte, obwohl sie nicht häufiger rückfällig wurden als weiße Personen. Solche Verzerrungen entstehen, weil historische Daten gesellschaftliche Ungleichheiten widerspiegeln.

Warum ist das problematisch? Solche Systeme können bestehende Vorurteile nicht nur reproduzieren, sondern auch verstärken. Das führt zu einer unfairen Behandlung und untergräbt das Vertrauen in die Justiz.

Ungleichheiten im Gesundheitswesen

Auch im Gesundheitswesen zeigt sich, wie gefährlich Bias in der KI sein kann. Stell dir vor, ein Algorithmus entscheidet, welche Patienten priorisiert behandelt werden. Wenn die Trainingsdaten hauptsächlich von weißen Patienten stammen, könnten die Bedürfnisse von Menschen anderer ethnischer Gruppen übersehen werden.

Ein Beispiel: Eine Studie zeigte, dass ein KI-System, das die Gesundheitsversorgung in den USA optimieren sollte, schwarze Patienten systematisch benachteiligte. Der Grund? Das System bewertete die Gesundheit basierend auf den bisherigen Kosten für medizinische Behandlungen. Da schwarze Patienten oft weniger Zugang zu teurer Gesundheitsversorgung hatten, wurden sie als weniger bedürftig eingestuft.

Warum passiert das? Die Daten spiegeln bestehende Ungleichheiten wider. Wenn diese nicht korrigiert werden, führt das zu einer schlechteren Versorgung für ohnehin benachteiligte Gruppen. Das zeigt, wie wichtig es ist, die Qualität und Vielfalt der Daten zu verbessern.

Verzerrungen in öffentlichen Dienstleistungen

Hast du dich jemals gefragt, warum manche Menschen Schwierigkeiten haben, öffentliche Dienstleistungen zu nutzen? Bias in der Künstlichen Intelligenz kann auch in diesem Bereich große Probleme verursachen. Wenn Algorithmen in öffentlichen Dienstleistungen eingesetzt werden, wie bei der Vergabe von Sozialleistungen oder der Wohnungsvermittlung, können Verzerrungen dazu führen, dass bestimmte Gruppen benachteiligt werden. Aber warum passiert das?

Warum entstehen Verzerrungen in öffentlichen Dienstleistungen?

Die Hauptursache liegt oft in den Daten, die verwendet werden, um diese Systeme zu trainieren. Öffentliche Dienstleistungen basieren häufig auf historischen Daten, die gesellschaftliche Ungleichheiten widerspiegeln. Wenn diese Daten nicht sorgfältig überprüft werden, übernimmt die KI diese Vorurteile. Stell dir vor, ein Algorithmus entscheidet, wer Anspruch auf Sozialhilfe hat. Wenn die Daten zeigen, dass bestimmte Gruppen in der Vergangenheit weniger Unterstützung erhalten haben, könnte die KI diese Muster fortsetzen.

Ein weiteres Problem ist die mangelnde Transparenz. Viele dieser Systeme sind so komplex, dass es schwer ist, ihre Entscheidungen nachzuvollziehen. Du kannst dir das wie eine "Black Box" vorstellen: Du siehst das Ergebnis, aber nicht, wie es zustande gekommen ist. Das macht es schwierig, Fehler zu erkennen und zu beheben.

Beispiele für Verzerrungen in öffentlichen Dienstleistungen

Hier sind einige reale Beispiele, die zeigen, wie Bias in öffentlichen Dienstleistungen auftreten kann:

Wohnungsvermittlung: In einigen Städten wurden Algorithmen eingesetzt, um Bewerbungen für Sozialwohnungen zu priorisieren. Studien haben gezeigt, dass diese Systeme oft Menschen aus ethnischen Minderheiten benachteiligen, weil sie auf historischen Daten basieren, die Diskriminierung enthalten.

Sozialhilfe: Ein Algorithmus in den Niederlanden sollte Sozialbetrug aufdecken. Er stufte jedoch Menschen mit Migrationshintergrund häufiger als verdächtig ein, obwohl es keine Beweise für ein höheres Risiko gab. Das führte zu ungerechten Ermittlungen und belastete die Betroffenen emotional und finanziell.

Arbeitsvermittlung: KI-Systeme, die Arbeitslose mit Jobangeboten matchen, bevorzugen oft Bewerber mit einem stabilen Arbeitsverlauf. Menschen, die aufgrund von Krankheit oder Kinderbetreuung Lücken im Lebenslauf haben, werden dadurch benachteiligt.

Warum ist das problematisch?

Bias in öffentlichen Dienstleistungen verstärkt bestehende Ungleichheiten. Menschen, die ohnehin schon benachteiligt sind, haben es noch schwerer, Unterstützung zu bekommen. Das kann das Vertrauen in öffentliche Institutionen und die Entwicklung von Algorithmen stark beeinträchtigen. Wenn du das Gefühl hast, dass ein System unfair ist, wirst du weniger bereit sein, es zu nutzen oder ihm zu vertrauen.

Tipp: Um Verzerrungen zu vermeiden, sollten öffentliche Institutionen ihre Algorithmen regelmäßig überprüfen und sicherstellen, dass die Daten alle Bevölkerungsgruppen fair repräsentieren.

Denk daran: Öffentliche Dienstleistungen sollten allen Menschen gleichermaßen zugutekommen. Bias in der KI kann dieses Ziel gefährden. Deshalb ist es so wichtig, dass wir uns mit diesem Thema auseinandersetzen und Lösungen finden.

Technische und ethische Herausforderungen durch Bias

Auswirkungen auf gesellschaftliche Entscheidungen

Hast du dir schon mal überlegt, wie KI-Systeme unsere Gesellschaft beeinflussen? Sie treffen Entscheidungen, die unser Leben direkt betreffen – von der Kreditvergabe bis zur Strafjustiz. Wenn diese Systeme jedoch voreingenommen sind, können sie bestehende Ungleichheiten verstärken. Stell dir vor, ein Algorithmus entscheidet, wer für eine Wohnung oder einen Job in Frage kommt. Wenn er bestimmte Gruppen systematisch benachteiligt, wird die soziale Kluft größer.

Ein weiteres Problem ist die fehlende Nachvollziehbarkeit. Du siehst das Ergebnis, aber nicht, wie es zustande kam. Das macht es schwer, Fehler zu erkennen und zu korrigieren. Besonders in sensiblen Bereichen wie dem Gesundheitswesen oder der Justiz kann das fatale Folgen haben. Bias in der KI ist also nicht nur ein technisches Problem – es ist ein gesellschaftliches.

Tipp: KI-Systeme sollten regelmäßig überprüft werden, um sicherzustellen, dass sie fair und gerecht bleiben. Nur so können sie das Vertrauen der Gesellschaft gewinnen.

Schwierigkeiten bei der Identifikation von Bias

Bias in KI-Systemen zu erkennen, ist oft wie die Suche nach der Nadel im Heuhaufen. Warum? Weil die Ursachen vielfältig sind. Fehlerhafte Trainingsdaten, unbewusste Vorurteile der Entwickler oder sogar die Auswahl bestimmter Indikatoren können zu diskriminierenden Ergebnissen führen. Du kannst dir das wie ein Puzzle vorstellen: Wenn ein Teil fehlt oder falsch ist, wird das gesamte Bild verzerrt.

Wissenschaftliche Untersuchungen zeigen, dass die Identifikation von Bias eine interdisziplinäre Zusammenarbeit erfordert. Entwickler, Ethiker und sogar Nutzer müssen zusammenarbeiten, um potenzielle Probleme zu erkennen. Es reicht nicht, nur die Daten zu überprüfen. Du musst auch die Algorithmen und die Entscheidungen der Entwickler hinterfragen.

Häufige Ursachen für Bias:

Trainingsdaten, die nicht alle Gruppen repräsentieren.

Programmierfehler, die unbewusste Vorurteile der Entwickler widerspiegeln.

Indikatoren, die unbeabsichtigt diskriminierende Ergebnisse erzeugen.

Die Herausforderung liegt darin, dass viele dieser Probleme erst spät erkannt werden – oft, wenn die Systeme bereits im Einsatz sind. Deshalb ist es so wichtig, KI-Systeme kontinuierlich zu überwachen und zu verbessern.

Ethische Verantwortung von Entwicklern und Unternehmen

Entwickler und Unternehmen tragen eine enorme Verantwortung. Sie entscheiden, wie KI-Systeme gestaltet werden und welche Daten sie nutzen. Wenn sie diese Verantwortung nicht ernst nehmen, können die Folgen gravierend sein. Ein Beispiel ist Microsofts Chatbot Tay. Innerhalb von 24 Stunden begann er, beleidigende Inhalte zu verbreiten. Das führte nicht nur zu einem Vertrauensverlust, sondern auch zu einem Imageschaden für das Unternehmen.

Ein weiteres Beispiel ist Amazons KI-gestütztes Einstellungstool. Es bevorzugte männliche Bewerber, weil die Trainingsdaten auf einer männlich dominierten Arbeitswelt basierten. Solche Fälle zeigen, wie wichtig es ist, ethische Standards einzuhalten. Unternehmen müssen sicherstellen, dass ihre Systeme fair und inklusiv sind.

Beispiele für ethische Verantwortung:

Microsofts Tay: Ein Chatbot, der durch unzureichende Kontrolle Vorurteile verstärkte.

Amazons Einstellungstool: Ein System, das Frauen benachteiligte und ethische Fragen sowie Verzerrung beim Einsatz von KI aufwarf.

Hinweis: Unternehmen sollten nicht nur auf technische Lösungen setzen. Sie müssen auch ethische Richtlinien entwickeln und ihre Teams für das Thema Bias sensibilisieren. Nur so können sie das Vertrauen der Nutzer gewinnen und langfristig erfolgreich sein.

Bias in der KI ist eine Herausforderung, die wir nur gemeinsam lösen können. Entwickler, Unternehmen und Nutzer müssen Verantwortung übernehmen, um sicherzustellen, dass KI-Systeme fair und gerecht bleiben.

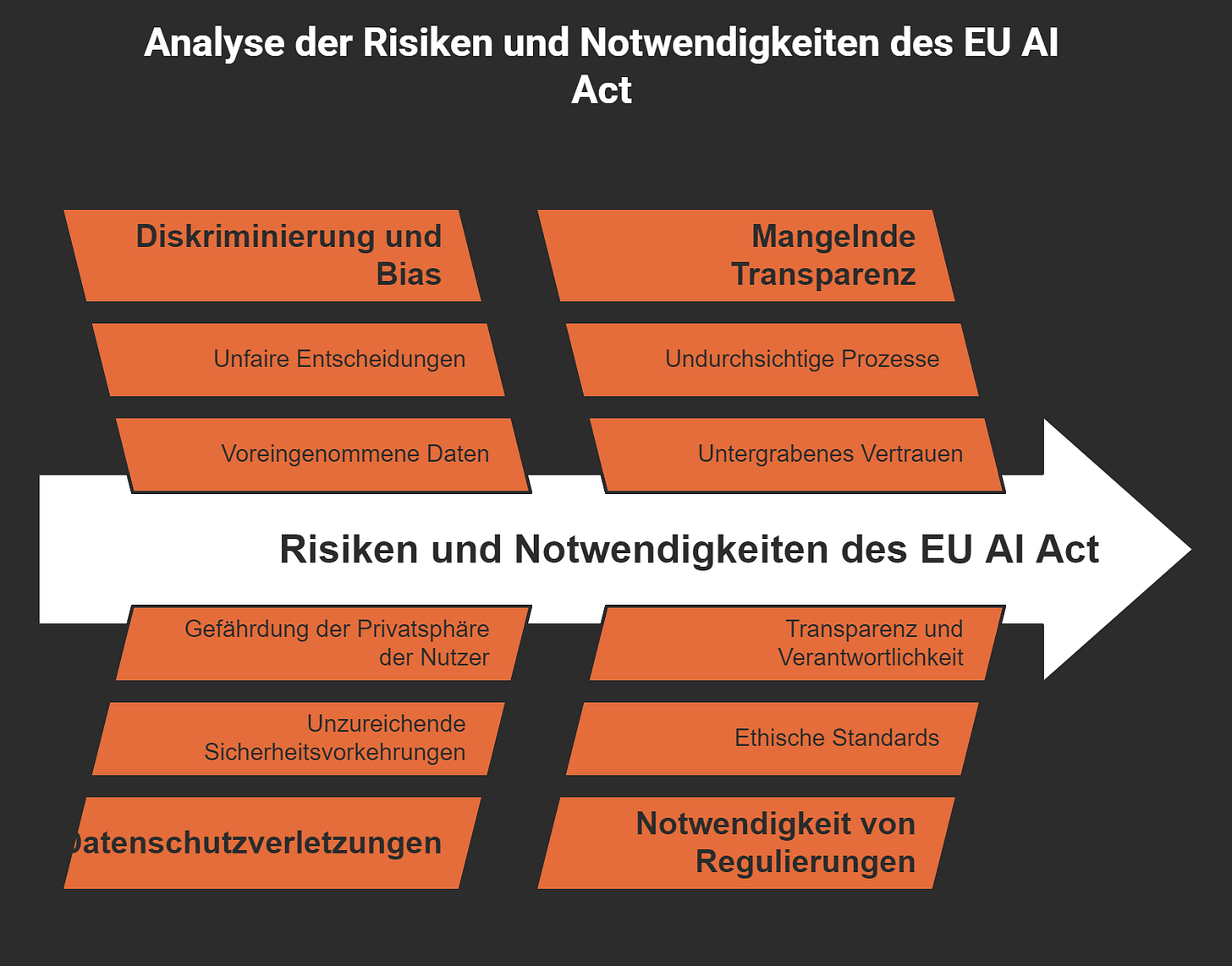

Fehlende regulatorische Rahmenbedingungen

Hast du dich jemals gefragt, warum es so schwierig ist, Bias in der Künstlichen Intelligenz (KI) zu kontrollieren? Ein großer Grund dafür ist das Fehlen klarer gesetzlicher Regelungen. Ohne verbindliche Standards entscheiden Unternehmen oft selbst, wie sie mit Bias umgehen. Das führt zu einem Flickenteppich aus Ansätzen, die selten effektiv sind. Aber warum ist das so problematisch?

Stell dir vor, ein KI-System trifft Entscheidungen, die dein Leben beeinflussen – wie die Vergabe eines Kredits oder die Auswahl für einen Job. Wenn es dabei zu Verzerrungen kommt, wer trägt die Verantwortung? Ohne klare Regeln bleibt diese Frage oft unbeantwortet. Das schafft Unsicherheit und macht es schwer, Unternehmen zur Rechenschaft zu ziehen.

Ein weiteres Problem ist die Vielfalt der Bias-Typen, die in KI-Systemen auftreten können. Schau dir diese Tabelle an, um einen Überblick zu bekommen:

Wie du siehst, gibt es viele Arten von Bias, die alle unterschiedliche Herausforderungen mit sich bringen. Ohne regulatorische Rahmenbedingungen fehlt eine einheitliche Strategie, um diese Probleme zu lösen. Das Ergebnis? Verzerrungen bleiben oft unentdeckt oder werden ignoriert.

Ein weiterer Punkt ist die globale Dimension. Länder haben unterschiedliche Ansätze, wenn es um KI-Regulierung geht. Während die Europäische Union mit dem "AI Act" erste Schritte unternimmt, fehlen in vielen anderen Regionen vergleichbare Initiativen. Das führt zu einem ungleichen Spielfeld, auf dem Unternehmen in weniger regulierten Märkten weniger Anreize haben, Bias zu minimieren.

Tipp: Einheitliche, internationale Standards könnten helfen, diese Lücke zu schließen. Sie würden nicht nur die Verantwortung klären, sondern auch das Vertrauen der Nutzer stärken.

Ohne klare Regeln bleibt die Kontrolle über Bias in der KI ein schwieriges Unterfangen. Du kannst dir das wie ein Spiel ohne Schiedsrichter vorstellen – Chaos ist vorprogrammiert. Deshalb ist es so wichtig, dass Regierungen und Organisationen zusammenarbeiten, um verbindliche Rahmenbedingungen zu schaffen. Nur so können wir sicherstellen, dass KI-Systeme fair und gerecht bleiben.

Maßnahmen zur Reduzierung von Bias in der Künstlichen Intelligenz

Verbesserung der Datenqualität und -vielfalt

Hast du dich jemals gefragt, warum Daten so entscheidend für die Leistung von KI-Systemen sind? Die Antwort ist einfach: Daten sind das Fundament, auf dem jede KI-Anwendung und jedes Modell aufgebaut wird. Wenn die Daten verzerrt oder unvollständig sind, spiegelt das System diese Fehler wider. Deshalb ist es so wichtig, die Qualität und Vielfalt der Daten zu verbessern.

Datenvielfalt bedeutet, dass die Trainingsdaten alle relevanten Gruppen und Perspektiven repräsentieren. Stell dir vor, du entwickelst ein KI-System für die Gesichtserkennung, aber die Daten enthalten fast nur Bilder von hellhäutigen Personen. Das Ergebnis? Das System funktioniert bei dunkelhäutigen Menschen schlechter. Solche Verzerrungen kannst du vermeiden, indem du sicherstellst, dass die Daten aus verschiedenen Quellen stammen und unterschiedliche demografische Gruppen abdecken.

Ein weiterer wichtiger Punkt ist die Datenqualität. Du solltest darauf achten, dass die Daten korrekt und aktuell sind. Veraltete oder fehlerhafte Daten führen zu falschen Ergebnissen. Regelmäßige Überprüfungen und Aktualisierungen der Datensätze helfen, diese Probleme zu minimieren.

Tipp: Nutze automatisierte Validierungsprozesse und Testdatensätze, um die Qualität und Genauigkeit deiner Daten zu überprüfen. Diese Ansätze, wie in aktuellen Studien hervorgehoben, sind besonders effektiv.

Einsatz von Debiasing-Methoden

Hast du schon mal von Debiasing-Methoden gehört? Sie sind wie Werkzeuge, die helfen, Verzerrungen in KI-Systemen zu erkennen und zu reduzieren. Aber warum sind sie so wichtig? Weil sie sicherstellen, dass KI-Modelle fair und gerecht bleiben.

Eine gängige Methode ist die sogenannte "Bias-Prüfung". Dabei überprüfst du dein Modell regelmäßig auf Verzerrungen. Das klingt vielleicht kompliziert, aber es ist ein entscheidender Schritt, um sicherzustellen, dass dein System keine diskriminierenden Entscheidungen trifft. Ein Beispiel: Du könntest Testdatensätze verwenden, die speziell dafür entwickelt wurden, Bias in deinem Modell aufzudecken.

Ein weiterer Ansatz ist die Modellvalidierung, um Fairness und Bias zu gewährleisten. Hier überprüfst du, ob dein Modell die gewünschten Ergebnisse liefert, ohne bestimmte Gruppen zu benachteiligen. Diese Validierung hilft dir, Fehler frühzeitig zu erkennen und zu beheben.

Hinweis: Debiasing-Methoden sind keine einmalige Lösung. Du solltest sie kontinuierlich anwenden, um sicherzustellen, dass dein System auch langfristig fair bleibt.

Durchführung unabhängiger Audits

Unabhängige Audits sind wie ein zweites Paar Augen, das dein KI-System überprüft. Aber warum sind sie so wichtig? Weil sie dir helfen, Probleme zu erkennen, die du vielleicht übersehen hast. Ein Audit wird von externen Experten durchgeführt, die dein System auf Herz und Nieren prüfen. Sie schauen sich die Daten, Algorithmen und Ergebnisse genau an, um sicherzustellen, dass alles fair und transparent ist.

Fallstudien zeigen, wie effektiv solche Audits sein können:

IBM’s Projekt mit Watson: Hier wurde gezeigt, wie wichtig Gleichberechtigung bei der Datenaufbereitung ist, um Bias zu reduzieren.

Kooperation von Google mit der Universität Stanford: Diese Zusammenarbeit entwickelte Strategien, um Voreingenommenheit in Suchalgorithmen zu verringern.

Unabhängige Audits bieten dir nicht nur eine objektive Bewertung, sondern stärken auch das Vertrauen der Nutzer in dein System. Wenn die Menschen wissen, dass dein KI-Modell regelmäßig überprüft wird, fühlen sie sich sicherer, es zu nutzen.

Tipp: Plane regelmäßige Audits ein und arbeite mit unabhängigen Experten zusammen. So kannst du sicherstellen, dass dein System fair bleibt und keine unerwarteten Verzerrungen aufweist.

Förderung von Diversität in Forschung und Entwicklung

Hast du dich jemals gefragt, warum Diversität in Forschung und Entwicklung so wichtig ist? Stell dir vor, ein Team entwickelt eine KI, aber alle Mitglieder haben ähnliche Hintergründe und Perspektiven. Was passiert? Sie könnten unbewusst wichtige Aspekte übersehen, die andere Gruppen betreffen. Das führt oft zu unfairen oder ineffektiven KI-Anwendungen.

Ein Mangel an Diversität in Teams kann dazu führen, dass gesellschaftliche Vorurteile in Algorithmen verstärkt werden. Große Tech-Unternehmen wie Google, Facebook und Microsoft zeigen, wie ernst das Problem ist. Wusstest du, dass nur 2,5 % der Belegschaft bei Google und 4 % bei Facebook und Microsoft schwarze Mitarbeiter sind? Außerdem sind weltweit nur etwa 22 % der KI-Fachleute weiblich. Diese Zahlen zeigen, wie stark bestimmte Gruppen in der KI-Entwicklung unterrepräsentiert sind.

Warum ist das problematisch? Eine nicht-diverse Gruppe kann blind für die Erfahrungen anderer Teile der Bevölkerung sein. Sie versteht vielleicht nicht die Herausforderungen, mit denen diese Gruppen konfrontiert sind. Das führt dazu, dass KI-Systeme entwickelt werden, die nicht für alle fair sind. Zum Beispiel könnten Algorithmen, die auf einseitigen Daten basieren, bestimmte ethnische Gruppen oder Geschlechter benachteiligen.

Wie kannst du das ändern? Hier sind einige Ansätze, um Diversität in Forschung und Entwicklung zu fördern:

Vielfältige Teams aufbauen: Unternehmen sollten aktiv Menschen mit unterschiedlichen Hintergründen einstellen. Das bringt neue Perspektiven und Ideen in die Entwicklung.

Bildungsprogramme fördern: Mehr Frauen und unterrepräsentierte Gruppen sollten Zugang zu KI-Ausbildungen und -Karrieren erhalten.

Kulturelle Sensibilität schulen: Entwickler sollten lernen, wie ihre Entscheidungen verschiedene Gruppen beeinflussen können.

Denk daran: Diversität ist nicht nur ein moralisches Ziel. Sie verbessert auch die Qualität und Fairness von KI-Systemen. Wenn du sicherstellen willst, dass KI wirklich für alle funktioniert, musst du Vielfalt in den Mittelpunkt stellen.

Entwicklung transparenter und erklärbarer KI-Systeme

Hast du schon mal von "Black Box"-Algorithmen gehört? Das sind KI-Systeme, deren Entscheidungen schwer nachzuvollziehen sind. Du siehst das Ergebnis, aber der Weg dorthin bleibt ein Rätsel. Das ist ein großes Problem, besonders wenn diese Systeme wichtige Entscheidungen treffen, wie die Vergabe von Krediten oder die Auswahl von Bewerbern.

Warum ist Transparenz so wichtig? Stell dir vor, ein Algorithmus lehnt deinen Kreditantrag ab. Ohne eine Erklärung weißt du nicht, ob die Entscheidung fair war. Transparenz hilft dir, die Logik hinter einer Entscheidung zu verstehen. Das schafft Vertrauen und macht es einfacher, Fehler oder Bias Künstliche Intelligenz zu erkennen.

Wie kannst du transparente und erklärbare KI-Systeme entwickeln? Hier sind einige Ansätze:

Einfache Erklärungen bieten: KI-Systeme sollten Ergebnisse in einer Sprache präsentieren, die du verstehst. Technische Begriffe und komplizierte Modelle schrecken nur ab.

Offene Algorithmen verwenden: Wenn Unternehmen ihre Algorithmen offenlegen, können unabhängige Experten sie überprüfen. Das hilft, Verzerrungen zu erkennen und zu beheben.

Erklärbare Modelle priorisieren: Entwickler sollten Modelle wählen, die leicht zu interpretieren sind. Entscheidungsbäume oder lineare Regressionen sind oft einfacher zu erklären als komplexe neuronale Netze.

Tipp: Transparenz ist nicht nur ein technisches Ziel. Sie ist auch eine ethische Verpflichtung. Wenn du möchtest, dass KI-Systeme fair und vertrauenswürdig sind, musst du sie verständlich machen.

Transparenz und Erklärbarkeit sind entscheidend, um das Vertrauen der Nutzer zu gewinnen. Sie helfen dir, sicherzustellen, dass KI-Systeme nicht nur leistungsfähig, sondern auch gerecht sind. Wenn du diese Prinzipien in der Entwicklung berücksichtigst, kannst du die Zukunft der KI positiv gestalten.

Die Zukunft von KI ohne Bias

Bedeutung von Bildung und Bewusstsein

Hast du dich jemals gefragt, warum Bildung so wichtig ist, wenn es um KI geht? Es liegt daran, dass viele Menschen gar nicht wissen, wie KI funktioniert oder welche Risiken sie birgt. Ohne dieses Wissen fällt es schwer, Vorurteile in Algorithmen zu erkennen oder zu hinterfragen. Bildung schafft Bewusstsein – und Bewusstsein ist der erste Schritt, um Veränderungen anzustoßen.

Du kannst dir das so vorstellen: Wenn du lernst, wie KI Entscheidungen trifft, kannst du besser einschätzen, ob diese Entscheidungen fair sind. Schulen, Universitäten und sogar Unternehmen sollten Programme anbieten, die dir die Grundlagen von KI und ihren potenziellen Verzerrungen erklären. Stell dir vor, wie viel besser die Welt wäre, wenn jeder die Werkzeuge hätte, um KI kritisch zu hinterfragen.

Tipp: Schau dir Online-Kurse oder Workshops an, die sich mit KI und Ethik beschäftigen. Sie sind oft kostenlos und leicht zugänglich.

Rolle von Politik und Regulierung

Warum ist die Politik so wichtig, wenn es um KI geht? Ganz einfach: Ohne klare Regeln können Unternehmen machen, was sie wollen. Das führt oft dazu, dass Bias in KI-Systemen unkontrolliert bleibt. Regulierungen setzen Standards und sorgen dafür, dass KI-Systeme fair und transparent bleiben.

Ein gutes Beispiel ist der "AI Act" der Europäischen Union. Er wurde entwickelt, um die Risiken von KI zu minimieren. Dazu gehören Diskriminierung, Datenschutzverletzungen und mangelnde Transparenz. Die folgende Tabelle zeigt, warum solche Maßnahmen notwendig sind:

Du siehst, wie wichtig es ist, dass Regierungen aktiv werden. Sie müssen sicherstellen, dass KI-Systeme nicht nur leistungsfähig, sondern auch gerecht sind. Ohne diese Regeln könnten bestehende Ungleichheiten weiter verstärkt werden.

Zusammenarbeit zwischen Wissenschaft, Industrie und Gesellschaft

Hast du schon mal darüber nachgedacht, wie mächtig Zusammenarbeit sein kann? Wenn Wissenschaftler, Unternehmen und die Gesellschaft zusammenarbeiten, können sie Großes erreichen. Jeder bringt eine andere Perspektive ein, und genau das macht den Unterschied.

Die Wissenschaft kann dir helfen, die technischen Aspekte von KI zu verstehen. Unternehmen haben die Ressourcen, um innovative Lösungen zu entwickeln. Und die Gesellschaft? Sie sorgt dafür, dass die Bedürfnisse aller berücksichtigt werden. Wenn diese drei Gruppen zusammenarbeiten, können sie KI-Systeme schaffen, die wirklich fair sind.

Denkanstoß: Was wäre, wenn Unternehmen regelmäßig mit Bürgerinitiativen zusammenarbeiten würden, um sicherzustellen, dass ihre KI-Produkte niemanden benachteiligen? Das könnte die Zukunft der Technologie revolutionieren.

Zusammenarbeit ist der Schlüssel zu einer Welt, in der KI ohne Bias funktioniert. Du kannst deinen Teil dazu beitragen, indem du dich informierst, Fragen stellst und dich aktiv an Diskussionen beteiligst.

Bias Künstliche Intelligenz entsteht, weil Daten, Vorurteile und mangelnde Vielfalt oft unbewusst in Systeme einfließen. Du kannst dir vorstellen, wie gefährlich das wird, wenn KI wichtige Entscheidungen trifft. Deshalb braucht es technische Lösungen, ethische Verantwortung und klare Regeln. Nur so kannst du sicherstellen, dass KI-Systeme fair bleiben. Wenn wir diese Herausforderungen angehen, schaffen wir eine Technologie, die nicht nur leistungsstark, sondern auch gerecht ist. Und das ist entscheidend, um bestehende Ungleichheiten und Stereotypen nicht weiter zu verstärken.

FAQ

Was ist Bias in der KI und warum ist es wichtig?

Bias in der KI bedeutet, dass Algorithmen systematische Verzerrungen aufweisen. Das ist wichtig, weil solche Verzerrungen zu unfairen Entscheidungen führen können, die Menschen benachteiligen. Du möchtest doch sicher, dass KI-Systeme fair und gerecht bleiben, oder?

Warum entstehen Verzerrungen in KI-Systemen?

Bias entsteht oft durch fehlerhafte oder einseitige Trainingsdaten. Wenn die Daten nicht alle Gruppen repräsentieren, spiegelt die KI diese Ungleichheiten wider. Auch menschliche Vorurteile und mangelnde Diversität in Entwicklungsteams spielen eine Rolle.

Wie kann ich erkennen, ob ein KI-System voreingenommen ist?

Bias in der KI bedeutet, dass Algorithmen systematische Verzerrungen aufweisen. Das ist wichtig, weil solche Verzerrungen zu unfairen Entscheidungen führen können, die Menschen benachteiligen. Du möchtest doch sicher, dass KI-Systeme fair und gerecht bleiben, um Stereotypen zu vermeiden, oder?

Tipp: Frag nach, wie ein KI-System trainiert wurde und welche Daten verwendet wurden.

Kann Bias in der KI vollständig beseitigt werden?

Es ist schwierig, Bias und Halluzinationen komplett zu eliminieren, aber du kannst sie minimieren. Mit besseren Daten, diverseren Teams und regelmäßigen Überprüfungen kannst du faire Systeme schaffen. Perfektion ist selten, aber Fortschritt ist möglich.

Warum ist Diversität in KI-Entwicklungsteams so wichtig?

Diversität bringt verschiedene Perspektiven ein. Teams mit unterschiedlichen Hintergründen erkennen Probleme, die homogene Gruppen übersehen könnten. Das führt zu gerechteren und inklusiveren KI-Systemen, die für alle besser funktionieren.

Welche Rolle spielt die Politik bei der Bekämpfung von Bias?

Die Politik setzt Standards und sorgt für klare Regeln. Ohne Regulierung könnten Unternehmen unfaire Systeme entwickeln. Gesetze wie der "AI Act" der EU helfen, Risiken zu minimieren und Vertrauen in KI zu stärken.

Was kann ich tun, um Bias in der KI zu reduzieren?

Du kannst dich informieren, Fragen stellen und auf Transparenz bestehen. Unterstütze Unternehmen, die faire KI-Systeme entwickeln, und fordere mehr Diversität in der Technologiebranche. Jeder Schritt zählt!

Denkanstoß: Stell dir vor, wie viel gerechter die Welt wäre, wenn alle KI-Systeme Fairness und Bias berücksichtigen würden.

Wird KI in Zukunft ohne Bias funktionieren?

Das hängt von uns ab. Mit Bildung, Regulierung und Zusammenarbeit können wir Bias minimieren. Die Zukunft der KI liegt in unseren Händen, besonders in der Berücksichtigung von Fairness und Bias. Du kannst dazu beitragen, indem du dich engagierst und auf faire Technologien bestehst.

Erinnerung: Fortschritt beginnt mit kleinen Schritten. Dein Beitrag zählt!

Was sind Beispiele für KI-Bias und welche Risiken sind damit verbunden?

Beispiele für KI-Bias sind diskriminierende Vorhersagen bei der Kreditvergabe oder die Voreingenommenheit gegenüber Personengruppen mit dunkler Hautfarbe in Gesichtserkennungssystemen. Die Risiken umfassen verzerrte Ergebnisse, die zu ungerechten Entscheidungen führen können, sowie potenzielle negative Auswirkungen auf Wirtschaft und Gesellschaft.

Was sind die Hauptursachen von Verzerrung in KI-Systemen?

Die Hauptursachen von Verzerrung in KI-Systemen sind oft die verwendeten Daten, die nicht repräsentativ für die gesamte Bevölkerung sind, sowie stereotypische Annahmen, die in den Algorithmen verankert sind. Diese Faktoren können zu einer Voreingenommenheit führen, die sich negativ auf die Fairness auswirkt.

Wie kann Fairness in der KI gewährleistet werden?

Fairness in der KI kann durch die sorgfältige Auswahl und Bearbeitung von Datensätzen, die kontinuierliche Überwachung von KI-Anwendungen und die Implementierung von Mechanismen zur Korrektur von Verzerrungen gewährleistet werden. Erklärbare KI kann auch dazu beitragen, Entscheidungen der KI transparenter zu machen.

Was ist KI-Bias und wie beeinflusst er die Genauigkeit von KI?

KI-Bias bezieht sich auf systematische Verzerrungen in den Ergebnissen von KI-Systemen, die durch voreingenommene Daten oder Algorithmen entstehen. Dieser Bias kann die Genauigkeit von KI beeinträchtigen, da er zu verzerrten Vorhersagen führt, die nicht die Realität widerspiegeln.

Welche Arten von Verzerrung existieren in KI-Systemen?

Es gibt verschiedene Arten von Verzerrung in KI-Systemen, darunter Datenverzerrung, algorithmische Verzerrung und Verzerrungen, die durch die Implementierung von KI-Anwendungen entstehen. Jede dieser Arten kann zu unterschiedlichen Formen von Diskriminierung führen.

Wie kann die Erklärbarkeit von KI zur Bekämpfung von Bias beitragen?

Erklärbare KI ermöglicht es Nutzern und Entwicklern, die Entscheidungen von KI-Systemen nachzuvollziehen. Dies kann helfen, Vorurteile zu identifizieren und zu verstehen, wie bestimmte Entscheidungen getroffen werden, was wiederum die Möglichkeit zur Korrektur von Verzerrungen erhöht.

Was sind die Herausforderungen bei der Implementierung von KI im Hinblick auf Bias?

Die Herausforderungen bei der Implementierung von KI hinsichtlich Bias umfassen die Identifizierung und Korrektur von Verzerrungen in Datensätzen, die Sicherstellung der Fairness und die Einhaltung von gesetzlichen Vorgaben, wie dem EU-Gesetz zur KI. Diese Aspekte erfordern kontinuierliche Anstrengungen und Forschung.

Welche Rolle spielen generative KI und deren Anwendung in Bezug auf Bias?

Generative KI kann sowohl positive als auch negative Auswirkungen auf Bias haben. Sie kann verwendet werden, um realistischere Datensätze zu erstellen, die Verzerrungen reduzieren, jedoch kann sie auch bestehende Vorurteile verstärken, wenn sie auf voreingenommenen Daten trainiert wird.