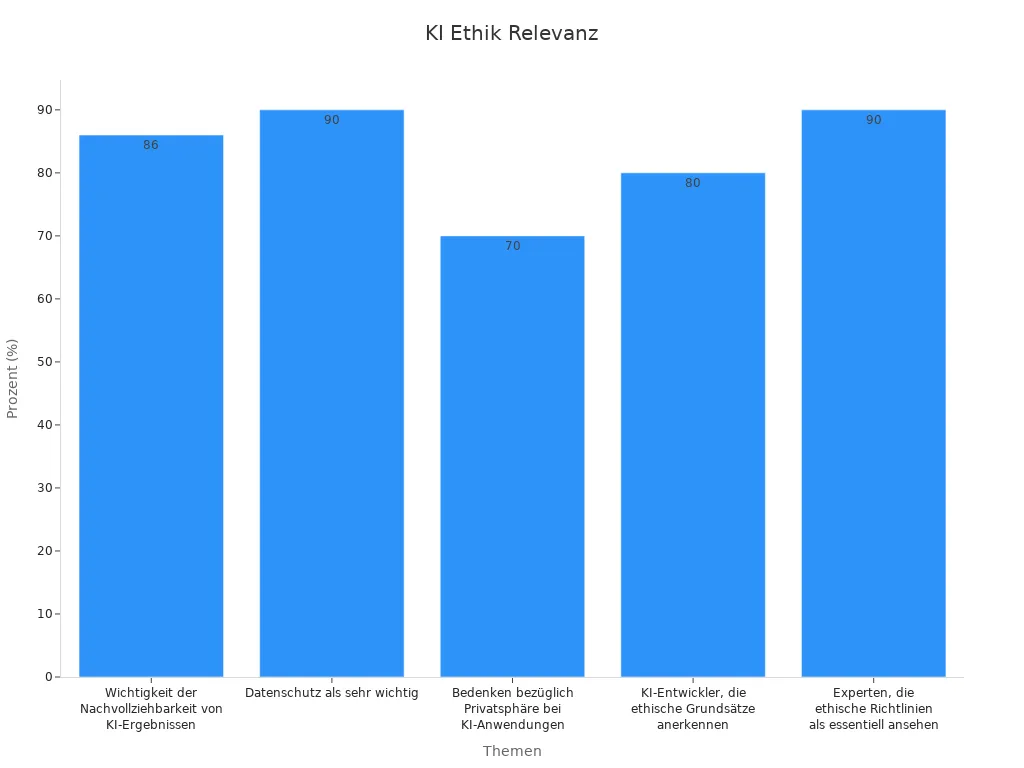

Datenschutz, Transparenz und Verantwortung stehen im Zentrum aktueller Diskussionen rund um Künstliche Intelligenz. Eine aktuelle Umfrage zeigt, dass 90 % der Experten ethische Richtlinien als essentiell betrachten. Die Gesellschaft fordert Nachvollziehbarkeit und Schutz der Privatsphäre, wie folgende Zahlen verdeutlichen:

Neue Technologien verändern Werte und Prinzipien. Gesellschaftliche Entwicklungen beeinflussen ethische Maßstäbe. Die Frage bleibt: Wie passen sich ethische Prinzipien an die rasante Entwicklung im Bereich der KI an?

Wichtige Erkenntnisse

Ethik in der Künstlichen Intelligenz schützt Menschenrechte und fördert Vertrauen durch Transparenz, Fairness und Datenschutz.

Entwickler und Unternehmen müssen KI-Systeme menschenzentriert gestalten, damit Nutzer Kontrolle und Autonomie behalten.

Klare Regeln, technische Normen und Ethik-Labels schaffen Orientierung und helfen, ethische Risiken frühzeitig zu erkennen.

Gesellschaftliche Debatten und internationale Zusammenarbeit prägen die Entwicklung von KI-Ethik und stärken die Verantwortung.

Regulierung und Weiterbildung sind entscheidend, um Innovationen mit ethischen Prinzipien in Einklang zu bringen.

Entwicklung der KI-Ethik

Anfänge

Die Geschichte der KI-Ethik beginnt in den 1950er Jahren. Alan Turing stellte die berühmte Frage: „Können Maschinen denken?“ und entwickelte den Turing-Test. John McCarthy prägte 1956 den Begriff „Künstliche Intelligenz“ und organisierte die Dartmouth-Konferenz, die als Geburtsstunde der KI gilt. Schon damals diskutierten Forscher grundlegende ethische Prinzipien. Sie fragten, wie Nutzer die Kontrolle über ihre Daten behalten und wie Systeme gestaltet werden können, damit sie keinen Schaden verursachen. Der Schutz der Privatsphäre und das Prinzip des Nichtschadens standen im Mittelpunkt. Diese frühen Überlegungen zeigen, dass ethische Herausforderungen von Anfang an Teil der KI-Entwicklung waren.

Wandel durch Technik

Mit dem technischen Fortschritt veränderten sich die ethischen Fragestellungen. Neue Anwendungen wie maschinelles Lernen, Spracherkennung und autonome Systeme stellten Entwickler und Gesellschaft vor neue Herausforderungen. Die Komplexität der Systeme wuchs. Entwickler mussten sich mit Fragen der Transparenz, Nachvollziehbarkeit und Sicherheit auseinandersetzen. Die Verantwortung für die Auswirkungen von KI-Systemen rückte stärker in den Fokus. Technische Innovationen führten dazu, dass ethische Prinzipien immer wieder neu bewertet werden mussten.

Gesellschaftlicher Einfluss

Gesellschaftliche und politische Veränderungen beeinflussen die Entwicklung der KI-Ethik maßgeblich. Studien zeigen, dass öffentliche Debatten und die Kommunikation von Führungskräften einen messbaren Einfluss haben:

Eine Analyse von LinkedIn-Aktivitäten von 100 CEOs im Jahr 2023 zeigte, dass gesellschaftliche Themen wie Ethik und Künstliche Intelligenz in der Kommunikation eine große Rolle spielen.

Untersuchungen von Vorständinnen aus DAX, MDAX und TechDAX belegen, dass weibliche Führungskräfte aktiver und nahbarer über ethische Fragen sprechen.

Eine Gemeinschaftsstudie mehrerer Universitäten belegte, dass KI-Modelle politische Voreingenommenheiten aufweisen.

Diese Studien zeigen, dass gesellschaftliche Faktoren und öffentliche Diskussionen die Wahrnehmung und Entwicklung von KI-Ethik prägen.

Gesellschaft und Technik stehen in einem ständigen Wechselspiel, das die ethischen Maßstäbe für Künstliche Intelligenz immer wieder neu definiert.

Künstliche Intelligenz und Ethik

Menschenzentrierte Entwicklung

Forschende und Unternehmen stellen den Menschen in den Mittelpunkt, wenn sie Künstliche Intelligenz entwickeln. Sie achten darauf, dass KI-Systeme die Rechte und Bedürfnisse der Nutzer respektieren. Viele Teams setzen auf klare Leitlinien, um Diskriminierung zu vermeiden und die Autonomie der Menschen zu schützen. Nutzer sollen verstehen, wie eine KI Entscheidungen trifft. Entwickler sorgen dafür, dass Menschen die Kontrolle behalten und Systeme nicht eigenständig handeln, ohne dass jemand eingreifen kann. Diese menschenzentrierte Herangehensweise stärkt das Vertrauen in neue Technologien.

KI-Ethikkodex

Ein KI-Ethikkodex legt verbindliche Regeln für den Umgang mit Künstlicher Intelligenz fest. Unternehmen wie Microsoft und Google haben solche Kodizes eingeführt. Sie verpflichten sich, ethische Prinzipien wie Transparenz, Fairness und Sicherheit in ihre Produkte zu integrieren. Die EU-KI-Gesetzgebung und Initiativen wie die AI Governance Alliance fördern die Entwicklung gemeinsamer Standards. Viele Organisationen führen unabhängige Audits durch und lassen ihre Systeme zertifizieren. Prominente Expertinnen und Experten wie Stuart Russell und Timnit Gebru setzen sich für die praktische Umsetzung ethischer Standards ein. Internationale Zusammenarbeit spielt dabei eine wichtige Rolle. Unternehmen berichten regelmäßig über ihre Fortschritte und Herausforderungen. Sie zeigen, dass ethische Fragen nicht nur theoretisch, sondern auch im Alltag der Industrie relevant sind.

Technische Normen

Technische Normen helfen, die Qualität und Sicherheit von KI-Systemen zu sichern. Sie legen fest, wie Entwickler Transparenz, Nachvollziehbarkeit und Datenschutz umsetzen. Internationale Organisationen wie die ISO oder das Deutsche Institut für Normung (DIN) arbeiten an solchen Standards. Diese Normen erleichtern die Überprüfung von KI-Anwendungen und schaffen Vertrauen bei Nutzern und Behörden. Sie unterstützen Unternehmen dabei, gesetzliche Vorgaben einzuhalten und Risiken frühzeitig zu erkennen. Technische Normen fördern die Vergleichbarkeit von Systemen und ermöglichen unabhängige Prüfungen.

Ethik-Labels

Ethik-Labels machen sichtbar, ob eine KI-Anwendung bestimmte ethische Anforderungen erfüllt. Sie funktionieren ähnlich wie bekannte Umwelt- oder Biosiegel. Ein Ethik-Label signalisiert, dass ein Produkt auf Fairness, Transparenz und Sicherheit geprüft wurde. Nutzer können sich so besser orientieren und bewusste Entscheidungen treffen. Unternehmen profitieren von mehr Glaubwürdigkeit und Wettbewerbsvorteilen. Einige Länder und Organisationen testen bereits erste Ethik-Labels für Künstliche Intelligenz. Diese Labels fördern den verantwortungsvollen Umgang mit neuen Technologien und stärken das Vertrauen der Gesellschaft.

Ein klarer Rahmen aus Leitlinien, Normen und Labels schafft Orientierung für alle, die mit Künstlicher Intelligenz arbeiten oder sie nutzen.

Ethische Prinzipien

Autonomie

Autonomie bedeutet, dass Menschen selbstbestimmt handeln und Entscheidungen treffen. Künstliche Intelligenz darf diese Freiheit nicht einschränken. Entwickler achten darauf, dass Nutzer die Kontrolle über Systeme behalten. Sie gestalten Anwendungen so, dass Menschen jederzeit eingreifen können. Autonomie schützt die Würde und die Rechte jedes Einzelnen.

Fairness

Fairness ist ein zentrales Prinzip bei der Entwicklung von Künstlicher Intelligenz. Viele Menschen sehen Chancen, aber auch Risiken:

Etwa 33 % der Befragten betrachten KI als Möglichkeit, Diskriminierung zu verhindern.

47 % schätzen KI als anfällig für Verzerrungen und Stereotype ein.

Über 8.000 Online-Kommentare zeigen, dass Technikoptimisten Diskriminierungspotenziale anerkennen, während Technikpessimisten Fairness selten thematisieren.

Fehlerhafte Gesichtserkennung bei dunkelhäutigen Menschen gilt als Beispiel für problematische Anwendungen.

Diskriminierung entsteht oft durch fehlerhafte oder verzerrte Daten, nicht durch die KI selbst.

Studien belegen, dass KI-Systeme gesellschaftliche Vorurteile widerspiegeln. Bildgeneratoren wie Firefly, StableDiffusion und DALL-E 3 zeigen unausgewogene Ergebnisse.

Die EU-Ethikleitlinien fordern Transparenz, Gerechtigkeit und Schutz der Grundrechte.

Fairness verlangt, dass alle Menschen gleich behandelt werden. Entwickler prüfen ihre Systeme regelmäßig auf mögliche Benachteiligungen.

Transparenz

Transparenz schafft Vertrauen in Künstliche Intelligenz. Nutzer sollen verstehen, wie ein System arbeitet und Entscheidungen trifft. Unternehmen setzen auf klare Prozesse:

Echtzeitüberwachung und automatisierte Priorisierung von Aufgaben.

Feedbackmechanismen steigern die Prognosegenauigkeit von 68 % auf 91 %.

Reaktionszeiten verkürzen sich von 14 Tagen auf 2 Tage.

Fehlererkennungsrate steigt durch IoT-Integration auf bis zu 97 %.

Transparente Kommunikation erhöht die Akzeptanz bei Mitarbeitern um 72 %.

Transparente Prozesse machen Abläufe nachvollziehbar und ermöglichen gezielte Verbesserungen.

Verantwortung

Verantwortung bedeutet, dass Entwickler und Unternehmen für die Folgen ihrer Systeme einstehen. Historische Erfahrungen zeigen, wie wichtig verbindliche Ethikrichtlinien sind:

Nach dem Zweiten Weltkrieg entstanden Leitlinien, die Freiwilligkeit und informierte Einwilligung fordern.

Fachgesellschaften entwickelten Kodizes, die Verantwortung und Transparenz sichern.

Wissenschaftsethik schützt vor Missbrauch und sorgt für gute Praxis.

Dokumentation und Offenlegung von Interessenskonflikten sind feste Bestandteile.

Verantwortung schützt Menschenrechte und fördert das Vertrauen in neue Technologien.

Datenschutz

Datenschutz schützt persönliche Informationen vor Missbrauch. Künstliche Intelligenz verarbeitet oft große Mengen sensibler Daten. Entwickler setzen technische und organisatorische Maßnahmen ein, um Daten zu sichern. Die DSGVO gibt klare Regeln vor. Nutzer behalten das Recht, über ihre Daten zu bestimmen. Datenschutz bleibt ein Grundpfeiler ethischer KI-Entwicklung.

Anwendungsbereiche

Medizin

Künstliche Intelligenz verändert die Medizin grundlegend. Ärzte nutzen KI-Systeme, um Diagnosen schneller und präziser zu stellen. Bildgebende Verfahren wie MRT oder CT profitieren von automatischer Auswertung. KI erkennt Muster, die für das menschliche Auge schwer sichtbar sind. In der Onkologie hilft sie, Tumore frühzeitig zu entdecken. Kliniken setzen KI auch bei der Verwaltung von Patientendaten ein. Das verbessert die Organisation und spart Zeit. Patienten profitieren von personalisierten Therapien, die auf großen Datenmengen basieren. Die Verantwortung für die finale Entscheidung bleibt jedoch immer beim medizinischen Fachpersonal.

Wirtschaft

Unternehmen setzen KI ein, um Prozesse effizienter zu gestalten. Im Handel analysieren Systeme das Kaufverhalten und optimieren Lagerbestände. Banken nutzen KI zur Betrugserkennung und Risikobewertung. In der Produktion steuern intelligente Maschinen Fertigungsstraßen und erkennen Fehler frühzeitig. Viele Firmen berichten von Kosteneinsparungen und höherer Produktivität. Die Einführung neuer Technologien stellt jedoch hohe Anforderungen an Datenschutz und IT-Sicherheit. Mitarbeitende müssen regelmäßig geschult werden, um mit den Veränderungen Schritt zu halten.

Öffentliche Verwaltung

Behörden profitieren von KI bei der Bearbeitung großer Datenmengen. Automatisierte Systeme helfen, Anträge schneller zu prüfen und Bürgeranfragen effizient zu beantworten. In der Steuerverwaltung erkennen Algorithmen Unregelmäßigkeiten und unterstützen bei der Betrugsbekämpfung. Digitale Assistenten erleichtern die Kommunikation mit Bürgern. Die Verwaltung muss jedoch sicherstellen, dass Entscheidungen nachvollziehbar bleiben. Transparenz und Datenschutz stehen im Mittelpunkt aller Anwendungen.

Autonome Systeme

Autonome Systeme spielen eine zentrale Rolle in der modernen Industrie und im Verkehr. Besonders im Bereich autonomes Fahren und Industrie 4.0 zeigen sich große Fortschritte. Forschende arbeiten an Methoden, um die Wahrnehmung von Maschinen zu verbessern. Das Fraunhofer-Institut für Kognitive Systeme IKS entwickelt Softwarearchitekturen, die KI-Entscheidungen auf Plausibilität prüfen. Dynamisches Safety-Management kann Fehlentscheidungen abfangen und so die Sicherheit erhöhen. Die Zuverlässigkeit hängt stark von der Qualität der Trainingsdaten ab. Herausforderungen wie Overfitting oder Underfitting beeinflussen die Sicherheit. Fehlentscheidungen können Menschenleben gefährden, daher bleibt die Absicherung ein zentrales Thema.

Herausforderungen

Regulierung

Regulierung bildet das Fundament für einen verantwortungsvollen Umgang mit Künstlicher Intelligenz. Gesetzgeber in Europa setzen auf strenge Datenschutzrichtlinien wie die DSGVO. Diese Vorgaben schützen persönliche Daten und schaffen Vertrauen. In anderen Regionen existieren weniger strenge Regeln. Unternehmen müssen sich an unterschiedliche Gesetze anpassen. Die Regulierung bleibt eine Herausforderung, weil technologische Entwicklungen oft schneller voranschreiten als gesetzliche Anpassungen.

Gesellschaftliche Verantwortung

Gesellschaftliche Verantwortung verlangt, dass Unternehmen und Entwickler ethische Prinzipien beachten. Studien wie die von McKinsey und das bidt zeigen, dass Fairness, Transparenz und Datenschutz zentrale Themen sind. Die bidt-Studie befragte rund 3.000 Internetnutzende in Deutschland. Sie untersuchte, wie Menschen Künstliche Intelligenz nutzen und welche Erwartungen sie an ethisches Handeln stellen. Die Ergebnisse betonen die Bedeutung von Weiterbildung und klaren Regeln im Umgang mit KI-Systemen.

Unternehmen, die gesellschaftliche Verantwortung übernehmen, stärken das Vertrauen der Nutzer und fördern die Akzeptanz neuer Technologien.

Innovation vs. Ethik

Innovative KI-Anwendungen bieten viele Chancen, bringen aber auch Risiken mit sich. Einige Beispiele verdeutlichen das Spannungsfeld:

Gesichtserkennung ermöglicht neue Überwachungsmethoden, wirft aber Fragen zum Datenschutz auf.

Automatisierte Bewerbungsverfahren können Vorurteile verstärken.

Generative KI schafft kreative Inhalte, stellt jedoch das Urheberrecht infrage.

Der AI Act setzt Leitlinien für Transparenz, Fairness und Sicherheit. Diese Regeln helfen, Innovation und Ethik in Einklang zu bringen.

Globale Perspektiven

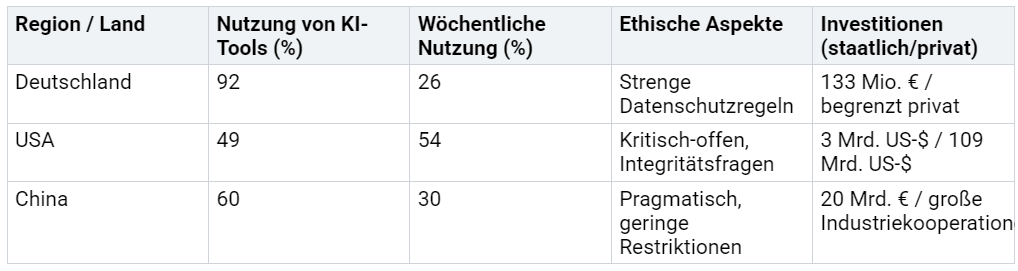

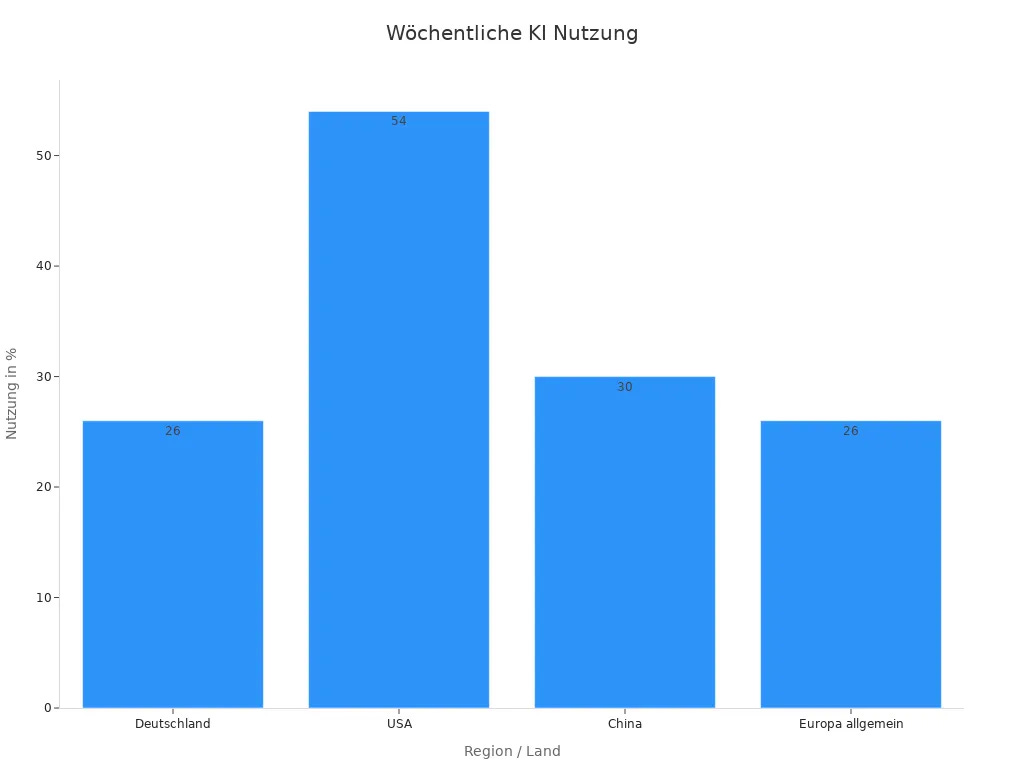

Die ethischen Ansätze im Umgang mit Künstlicher Intelligenz unterscheiden sich weltweit. Ein Vergleich zeigt deutliche Unterschiede:

Europa setzt auf Datenschutz und ethische Leitlinien. China verfolgt einen pragmatischen Ansatz. Die USA investieren stark und diskutieren intensiv über Integrität. Diese Unterschiede prägen die globale Entwicklung von KI-Ethik.

Zukunft der KI-Ethik

Neue Fragestellungen

Neue Technologien werfen ständig neue ethische Fragen auf. Prognosemodelle und statistische Verfahren verändern die Entscheidungsfindung in vielen Branchen. Unternehmen wie Siemens, BMW und Volkswagen nutzen KI, um Markttrends vorherzusagen und Produktionsprozesse zu optimieren. Medizinische Einrichtungen wie die Mayo Clinic erzielen mit KI-gestützten Diagnosen Genauigkeiten von bis zu 95 %. Diese Entwicklungen bringen Herausforderungen mit sich:

Bias in Trainingsdaten kann zu unfairen Ergebnissen führen.

Datenschutz bleibt eine zentrale Anforderung, besonders bei sensiblen Informationen.

Transparenz in der Entscheidungsfindung wird immer wichtiger.

Die Verantwortung für automatisierte Entscheidungen muss klar geregelt sein.

Big Data eröffnet neue Möglichkeiten, verlangt aber auch neue ethische Leitlinien.

Gesellschaftliche Debatten über Gesichtserkennung und automatisierte Systeme zeigen, wie wichtig klare Regeln und Weiterbildung sind.

Internationale Zusammenarbeit

Internationale Kooperationen fördern ethische Standards und Innovationen. Über 120 Staaten beteiligen sich am UN-Globalen Digitalpakt, der ethische Rahmenbedingungen für KI-Anwendungen schafft. 47 UN-Einheiten setzen KI gezielt zur Erreichung der nachhaltigen Entwicklungsziele ein. Frühwarnsysteme in Krisenregionen wie Mali und der Demokratischen Republik Kongo verkürzen Reaktionszeiten durch KI-gestützte Apps erheblich. Partnerschaften wie SDG-17 verbinden lokales Wissen mit globalen Technologien. Das Deutsche Forschungszentrum für Künstliche Intelligenz arbeitet mit Partnern an Prüfstandards, die Transparenz und Nichtdiskriminierung messbar machen.

Verantwortung für die Zukunft

Verantwortung für die Zukunft bedeutet, ethische Prinzipien aktiv zu gestalten. Unternehmen und Forschungseinrichtungen entwickeln transparente Verfahren und schulen Mitarbeitende regelmäßig. Ethikkommissionen begleiten Projekte von Anfang an. Internationale Standards fördern eine menschenzentrierte und faire Nutzung von KI. Die Gesellschaft erwartet, dass Entwickler und Entscheidungsträger Risiken frühzeitig erkennen und Maßnahmen ergreifen. Nur so entsteht nachhaltiges Vertrauen in neue Technologien.

Die Ethik der Künstlichen Intelligenz entwickelt sich stetig weiter. Gesellschaft, Politik und Wirtschaft tragen gemeinsam Verantwortung für einen ausgewogenen Umgang mit Innovation und ethischen Prinzipien. Neue Technologien erfordern klare Regeln und ständige Reflexion.

Nur wer ethische Fragen aktiv stellt, kann die Zukunft der KI verantwortungsvoll mitgestalten.

Gesellschaftliche Debatten stärken das Bewusstsein.

Politik setzt Rahmenbedingungen.

Unternehmen fördern Transparenz und Fairness.

Jeder kann einen Beitrag leisten und sollte sich mit den Herausforderungen der KI-Ethik auseinandersetzen.

FAQ

Was versteht man unter KI-Ethik?

KI-Ethik beschreibt die Prinzipien und Regeln, die den verantwortungsvollen Umgang mit Künstlicher Intelligenz steuern. Sie schützt Menschenrechte, fördert Fairness und sorgt für Transparenz. Unternehmen und Forschende orientieren sich an diesen Leitlinien, um Risiken zu minimieren.

Welche Rolle spielt Transparenz bei KI-Systemen?

Transparenz ermöglicht es Nutzern, Entscheidungen von KI-Systemen nachzuvollziehen. Sie schafft Vertrauen und hilft, Fehler frühzeitig zu erkennen. Unternehmen dokumentieren Abläufe und erklären, wie Algorithmen funktionieren. So bleibt die Kontrolle beim Menschen.

Wie können Unternehmen ethische Risiken bei KI minimieren?

Unternehmen führen regelmäßige Audits durch und setzen auf unabhängige Prüfungen. Sie schulen Mitarbeitende und entwickeln klare Richtlinien. Ethik-Labels und technische Normen unterstützen die Einhaltung von Standards. So lassen sich Risiken frühzeitig erkennen und vermeiden.

Gibt es internationale Unterschiede bei der KI-Ethik?

Verschiedene Länder setzen unterschiedliche Schwerpunkte. Europa legt Wert auf Datenschutz und Fairness. Die USA fördern Innovation und diskutieren Integrität. China verfolgt einen pragmatischen Ansatz mit weniger Restriktionen. Internationale Zusammenarbeit hilft, gemeinsame Standards zu entwickeln.