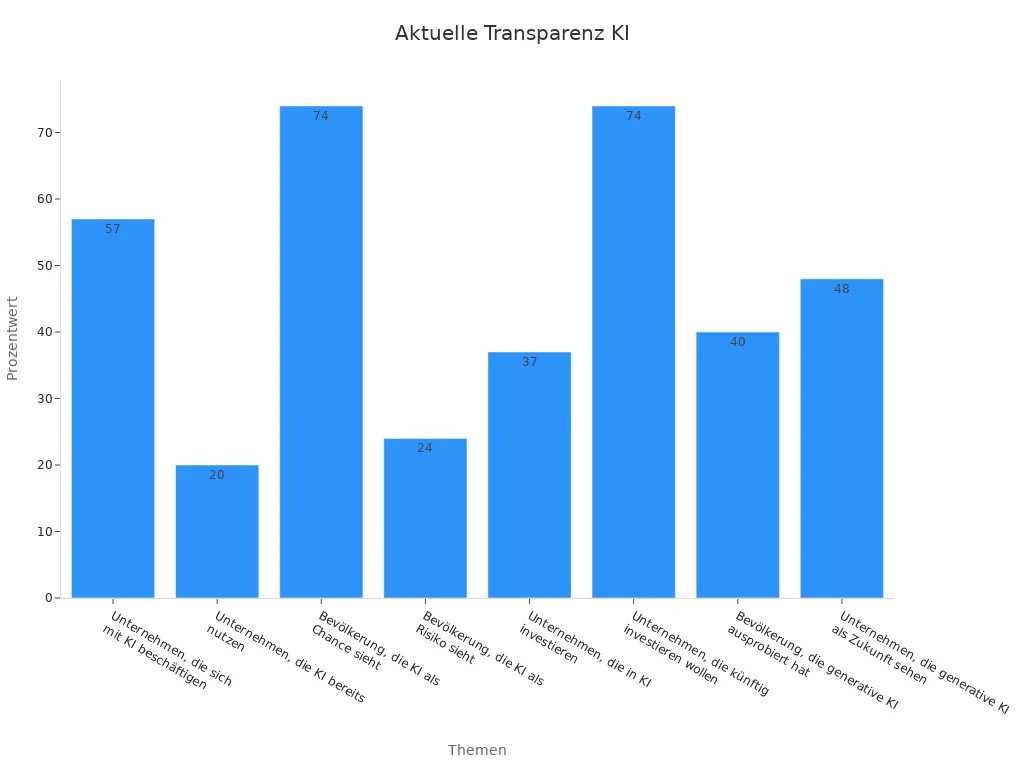

Transparenz entscheidet über das Vertrauen in Künstliche Intelligenz. Die Studie von BIDT zeigt, dass viele Unternehmen Transparenz nicht als Priorität sehen, obwohl 74 % der Bevölkerung KI als Chance betrachten und 24 % Risiken erkennen. Fehlende Nachvollziehbarkeit erschwert faire Entscheidungen und schwächt die Kontrolle. Eine klare Kommunikation von KI-Entscheidungen steigert nachweislich die Kundenzufriedenheit, wie eine Steigerung um 25 % im E-Commerce verdeutlicht. Unternehmen, Nutzer und Gesellschaft profitieren, wenn erklärbare Systeme Diskriminierung vermeiden und Vertrauen fördern.

Wichtige Erkenntnisse

Transparenz macht KI-Entscheidungen verständlich und stärkt das Vertrauen von Nutzern, Unternehmen und Gesellschaft.

Erklärbare KI-Methoden wie LIME und SHAP helfen, die Entscheidungswege von Modellen sichtbar und nachvollziehbar zu machen.

Transparente KI verhindert Diskriminierung, reduziert Fehlentscheidungen und sichert die Kontrolle über automatisierte Prozesse.

Gutes Datenmanagement und klare Kommunikation sind entscheidend für die Nachvollziehbarkeit und den Erfolg von KI-Systemen.

Unternehmen profitieren von transparenter KI durch höhere Effizienz, bessere Compliance und gesteigertes Kundenvertrauen.

Transparenz in Künstlicher Intelligenz

Bedeutung

Transparenz beschreibt, wie nachvollziehbar und verständlich die Funktionsweise von Künstlicher Intelligenz für Menschen ist. Ein transparentes KI-System zeigt offen, wie es zu seinen Entscheidungen kommt. Nutzer und Unternehmen profitieren davon, weil sie die Ergebnisse besser einschätzen und kontrollieren können. Besonders in sensiblen Bereichen wie Medizin, Finanzen oder öffentlicher Verwaltung spielt Transparenz eine zentrale Rolle. Sie hilft, Fehler frühzeitig zu erkennen und Diskriminierung zu vermeiden.

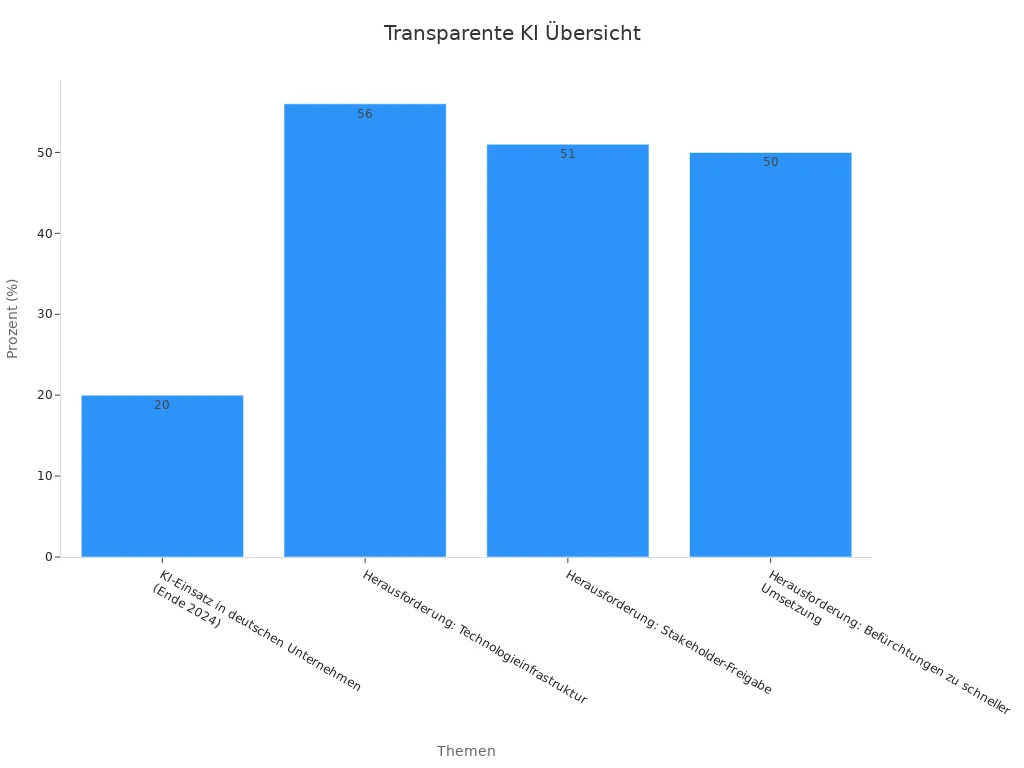

Viele Unternehmen erkennen die Bedeutung von Transparenz, stehen aber vor Herausforderungen. Die folgende Tabelle zeigt zentrale Erkenntnisse und Schwierigkeiten bei der Einführung von KI in der Industrie:

Erklärbare Künstliche Intelligenz (XAI) hilft, das sogenannte Black-Box-Problem zu lösen. Viele KI-Modelle liefern zwar genaue Ergebnisse, doch sie erklären nicht, wie sie zu diesen Ergebnissen kommen. XAI-Methoden wie LIME oder SHAP machen die Entscheidungswege sichtbar. Unternehmen können so besser nachvollziehen, warum ein System eine bestimmte Empfehlung gibt. Das stärkt die Kontrolle und hilft, gesetzliche Vorgaben einzuhalten.

Vertrauen

Vertrauen entsteht, wenn Menschen die Entscheidungen von Künstlicher Intelligenz verstehen und nachvollziehen können. Die Allensbach-Studie „KI-Assistenten und wir“ zeigt, dass 55 % der Nutzer den Ergebnissen von KI-Assistenten vertrauen. Bei Vielnutzern steigt dieser Wert sogar auf 64 %. Fast die Hälfte der Befragten prüft die Antworten zumindest gelegentlich. Besonders wichtig ist Transparenz für Nutzergruppen, die wenig Erfahrung mit KI haben. Sie sehen häufiger Risiken und wünschen sich klare Erklärungen und Quellenangaben.

Im Finanzsektor fordern Aufsichtsbehörden wie die SEC und ESMA mehr Offenheit bei KI-gestützten Analysen. Sie verlangen, dass Unternehmen offenlegen, wie ihre Modelle funktionieren und welche Daten sie nutzen. Ein „Human-in-the-Loop“-Ansatz, bei dem Menschen die finale Entscheidung treffen, stärkt das Vertrauen zusätzlich. Offen zugängliche Algorithmen und zertifizierte Audits sorgen für mehr Nachvollziehbarkeit.

Die wichtigsten Säulen des Vertrauens lassen sich in der folgenden Tabelle zusammenfassen:

Tipp: Transparente Künstliche Intelligenz fördert nicht nur das Vertrauen von Anwendern, sondern auch von Investoren und Regulierungsbehörden. Sie erleichtert die Zusammenarbeit zwischen Mensch und Maschine und hilft Unternehmen, gesetzliche Vorgaben einzuhalten.

Risiken der Künstlichen Intelligenz

Voreingenommenheit

Voreingenommenheit stellt ein zentrales Risiko bei Künstlicher Intelligenz dar. Ein Algorithmus übernimmt oft die Vorurteile aus den Trainingsdaten. Wenn Entwickler nicht auf eine ausgewogene Datenauswahl achten, entstehen diskriminierende Ergebnisse. Ein Beispiel: Ein Bewerbungsalgorithmus bevorzugt Bewerber aus bestimmten Regionen, weil die Trainingsdaten diese Gruppe überrepräsentieren. Solche Fehler führen zu Benachteiligungen und verstärken gesellschaftliche Ungleichheiten. Unternehmen müssen daher regelmäßig prüfen, ob ihre Systeme fair arbeiten.

Hinweis: Transparente Modelle helfen, Voreingenommenheit frühzeitig zu erkennen und zu beheben.

Fehlentscheidungen

Fehlentscheidungen entstehen, wenn Künstliche Intelligenz falsche Schlüsse zieht. Diese Fehler können schwerwiegende Folgen haben. Im Gesundheitswesen kann eine fehlerhafte Diagnose die Behandlung eines Patienten gefährden. In der Finanzbranche führen Fehlentscheidungen zu finanziellen Verlusten. Ohne Transparenz bleibt oft unklar, warum ein System eine bestimmte Entscheidung getroffen hat. Nutzer können Fehler nicht nachvollziehen oder korrigieren. Das Risiko steigt, wenn Unternehmen auf komplexe Black-Box-Modelle setzen.

Kontrolle

Kontrollverlust zählt zu den größten Gefahren intransparenter Systeme. Menschen verlieren die Übersicht, wenn sie nicht verstehen, wie eine KI arbeitet. Behörden und Unternehmen stehen vor der Herausforderung, Entscheidungen nachzuvollziehen und zu steuern. Fehlt die Kontrolle, drohen rechtliche Konsequenzen. Die Datenschutz-Grundverordnung (DSGVO) verlangt, dass Unternehmen erklären können, wie automatisierte Entscheidungen zustande kommen. Gesellschaften riskieren das Vertrauen der Bürger, wenn sie keine Kontrolle über Künstliche Intelligenz gewährleisten.

Gesellschaftliche Risiken: Diskriminierung, Vertrauensverlust, soziale Spaltung.

Rechtliche Risiken: Verstöße gegen Datenschutzgesetze, Haftungsfragen, regulatorische Sanktionen.

Methoden der XAI

LIME

LIME steht für „Local Interpretable Model-agnostic Explanations“. Diese Methode erklärt einzelne Vorhersagen von Modellen, indem sie das Verhalten in der Umgebung eines bestimmten Datenpunkts untersucht. LIME erstellt viele leicht veränderte Kopien der Eingabedaten und beobachtet, wie das Modell darauf reagiert. So erkennt das Verfahren, welche Merkmale den größten Einfluss auf die Entscheidung haben. Entwickler nutzen LIME, um komplexe Modelle verständlicher zu machen. Besonders bei sensiblen Anwendungen wie Kreditvergabe oder medizinischer Diagnose hilft LIME, Entscheidungen transparent zu begründen.

SHAP

SHAP („SHapley Additive exPlanations“) basiert auf Konzepten aus der Spieltheorie. Die Methode berechnet, wie stark jedes einzelne Merkmal zum Ergebnis eines Modells beiträgt. SHAP-Werte zeigen, ob ein Merkmal eine Entscheidung positiv oder negativ beeinflusst. Statistische Analysen vergleichen Kernel-SHAP-Werte mit etablierten Sensitivitätsindizes wie den Sobol-Indizes. Beide Ansätze quantifizieren die Bedeutung von Eigenschaften. Werte nahe 0 bedeuten keinen Einfluss, höhere Werte zeigen eine größere Bedeutung. Dieser Vergleich bestätigt, dass SHAP eine statistisch fundierte Methode zur Bewertung des Einflusses einzelner Merkmale in Modellen darstellt. Unternehmen setzen SHAP ein, um die Entscheidungswege ihrer Systeme nachvollziehbar zu machen und Vertrauen bei Anwendern zu schaffen.

Datenmanagement

Strukturiertes Datenmanagement bildet die Grundlage für transparente und nachvollziehbare KI-Systeme. Unternehmen profitieren von klaren Prozessen und hoher Datenqualität. Die folgenden Ergebnisse zeigen den Einfluss von Datenmanagement auf die Nachvollziehbarkeit:

Automatisierung in der Datenverarbeitung schafft bis zu 80 % mehr Kapazitäten für strategische Planungen.

Fehlerquote bei Schnittstellenanpassungen sinkt von 78 % auf 4 % durch automatisierte Lösungen.

Implementierung von Erklärbarkeits-Tools senkt Compliance-Risiken um 65 % und stärkt das Vertrauen der Stakeholder.

Ein Gesundheitsunternehmen dokumentiert jede Entscheidung, was die Nachvollziehbarkeit deutlich verbessert.

Ein Einzelhändler reduzierte Überbestände um 30 % und steigerte Liefertreue um 18 % durch prädiktive Modelle.

Einsatz von Entity-Relationship-Diagrammen (ERDs) führt zu 40 % weniger Datenredundanz und 35 % höherer Effizienz bei der Systemwartung.

Integration strukturierter Daten in ein zentrales Dashboard verkürzt Reaktionszeiten um 25 %, steigert Upselling-Möglichkeiten um 15 % und reduziert manuelle Datenabgleiche um 40 %.

Hinweis: Unternehmen, die auf Datenqualität und Governance achten, schaffen die Basis für erklärbare und vertrauenswürdige Systeme.

Vorteile transparenter KI

Unternehmen

Transparente KI-Systeme bieten Unternehmen klare Vorteile. Sie erleichtern die Einhaltung von Compliance-Vorgaben und steigern die Effizienz. Automatisierte Prozesse reduzieren menschliche Fehler und ermöglichen eine bessere Überwachung von Transaktionen. Unternehmen erkennen Risiken frühzeitig und können schneller reagieren. Der europäische AI-Act fordert Transparenz und Nachvollziehbarkeit, was die Einhaltung von Vorschriften unterstützt. Die folgende Tabelle zeigt, wie der Automatisierungsgrad die Effizienz steigert:

Nur wenige Unternehmen nutzen KI optimal. Wer jedoch auf transparente Systeme setzt, kann bis zu 80 % der manuellen Arbeiten automatisieren und Projektrisiken mit hoher Genauigkeit vorhersagen. Intelligente Berichte und automatisierte Audits verschaffen Wettbewerbsvorteile.

Nutzer

Nutzer profitieren von verständlichen und nachvollziehbaren Entscheidungen. Transparente Systeme stärken das Vertrauen und fördern die Akzeptanz. Studien zeigen, dass erklärbare KI das mentale Modell der Nutzer verbessert. Lehrkräfte und andere Anwender entwickeln eine positive Einstellung, wenn sie die Funktionsweise nachvollziehen können. Transparenz hilft, Unsicherheiten abzubauen und die Nutzung zu erleichtern.

Tipp: Nutzer, die Entscheidungen verstehen, nutzen KI-Systeme sicherer und gezielter.

Gesellschaft

Transparente KI fördert Fairness und Chancengleichheit. Gesellschaften profitieren, wenn Diskriminierung früh erkannt und verhindert wird. Offene Systeme ermöglichen eine bessere Kontrolle durch Behörden und stärken das Vertrauen der Bevölkerung. In der Medizin sorgt Transparenz für nachvollziehbare Diagnosen. Im Finanzsektor schützt sie vor ungerechten Entscheidungen. Unternehmen, Nutzer und Gesellschaft gewinnen gemeinsam, wenn KI nachvollziehbar bleibt.

Herausforderungen und Grenzen

Technische Limitationen

Viele technische Grenzen erschweren die Erklärbarkeit moderner KI-Systeme. Die Qualität und Verfügbarkeit der Trainingsdaten beeinflussen die Genauigkeit der Modelle. Fehlerhafte oder unvollständige Daten führen zu unzuverlässigen Ergebnissen und können das Vertrauen der Nutzer mindern. Besonders bei unstrukturierten Daten, wie Bildern oder Texten, stoßen Entwickler oft an ihre Grenzen. Mediziner berichten zum Beispiel von Unsicherheiten bei KI-gestützten Diagnosen, da die Systeme nicht immer nachvollziehbar arbeiten.

Komplexe Algorithmen, wie tiefe neuronale Netze, benötigen große Rechenressourcen. Das erschwert nicht nur die Analyse, sondern auch die Erklärung der Entscheidungen. Viele Methoden zur Erklärbarkeit, wie Counterfactual Explanations, sind rechenintensiv und lassen sich nicht immer in Echtzeit anwenden. Die Nachvollziehbarkeit leidet besonders bei generativen Systemen und großen Sprachmodellen, weil die Trainingsdaten oft nicht öffentlich zugänglich sind. Dadurch sinkt die Transparenz und die Risikoabschätzung wird schwieriger.

Tipp: Unternehmen sollten kontinuierlich ihre Datenmanagement- und IT-Infrastruktur anpassen, um technische Hürden zu überwinden und die Erklärbarkeit zu verbessern.

Offene Fragen

Die Forschung zur Erklärbarkeit von KI steht vor vielen offenen Fragen. Experten diskutieren, wie sich komplexe Modelle besser verständlich machen lassen. Verschiedene Methoden, wie Modelldestillation oder Attributionstechniken, helfen, Entscheidungswege sichtbar zu machen. Dennoch bleibt unklar, wie viel Transparenz Nutzer wirklich benötigen und wie sich Erklärungen am besten darstellen lassen.

Eine wichtige Herausforderung besteht darin, die Limitationen der Modelle zu erkennen. Dazu gehört die Analyse der Trainingsdaten, um mögliche Verzerrungen oder fehlende Gruppen zu identifizieren. Der Vergleich ähnlicher Daten mit unterschiedlichen Ergebnissen kann helfen, die Entscheidungsgrenzen eines Modells zu verstehen. Extremfälle in Datensätzen zeigen oft Schwachstellen auf.

KI kann keine echte Kreativität entwickeln.

Emotionale Intelligenz wird nur eingeschränkt nachgeahmt.

Ethische Richtlinien und Offenlegung von Algorithmen bleiben zentrale Themen.

Die Entwicklung verständlicher und zugleich leistungsfähiger Systeme bleibt ein zentrales Ziel für die Zukunft.

Transparenz bildet die Grundlage für verantwortungsvolle Künstliche Intelligenz. Unternehmen, Entwickler und Entscheidungsträger profitieren von klaren Handlungsempfehlungen:

Unsicherheiten bei KI-Antworten offen kommunizieren.

Nutzer:innen ermöglichen, Antworten zu validieren.

Quellen und Entscheidungswege transparent angeben.

Bereiche mit erhöhtem Prüfbedarf kennzeichnen.

Human-in-the-Loop-Ansätze integrieren.

Datenschutz, Fairness und Sicherheit gewährleisten.

Externe Prüfungen und klare Richtlinien umsetzen.

Über 90 % der Verbraucher:innen erwarten, dass Unternehmen Verantwortung übernehmen. Transparenz schafft Vertrauen und fördert nachhaltige Innovation.

FAQ

Was bedeutet Transparenz bei Künstlicher Intelligenz?

Transparenz beschreibt, wie verständlich und nachvollziehbar ein KI-System arbeitet. Nutzer erkennen, wie das System Entscheidungen trifft. Unternehmen zeigen offen, welche Daten und Methoden sie verwenden. So entsteht Vertrauen und Kontrolle.

Warum ist erklärbare KI (XAI) wichtig?

Erklärbare KI hilft Menschen, die Entscheidungen von Algorithmen zu verstehen. Sie zeigt, welche Faktoren das Ergebnis beeinflussen. Unternehmen erfüllen damit rechtliche Vorgaben und stärken das Vertrauen der Nutzer.

Welche Risiken entstehen durch intransparente KI?

Intransparente KI kann zu Diskriminierung, Fehlentscheidungen und Kontrollverlust führen. Nutzer erkennen Fehler oft zu spät. Unternehmen riskieren rechtliche Konsequenzen und verlieren das Vertrauen der Gesellschaft.

Wie profitieren Unternehmen von transparenter KI?

Unternehmen erfüllen mit transparenter KI gesetzliche Anforderungen leichter. Sie erkennen Risiken schneller und verbessern ihre Prozesse. Ein hoher Automatisierungsgrad steigert die Effizienz und stärkt das Kundenvertrauen.

Welche Methoden fördern die Transparenz in KI-Systemen?

Methoden wie LIME und SHAP erklären, wie ein Modell zu seinen Ergebnissen kommt. Strukturiertes Datenmanagement sorgt für nachvollziehbare Prozesse. Unternehmen nutzen diese Werkzeuge, um KI-Entscheidungen verständlich zu machen.