Die Einführung von WormGPT hat die Sicherheitslandschaft tiefgreifend verändert. Dieses KI-System wurde speziell entwickelt, um kriminelle Aktivitäten zu erleichtern. Es bietet eine Plattform, die Phishing-Mails und Schadsoftware mit minimalem Aufwand erzeugt. Unternehmen und Privatpersonen stehen dadurch vor neuen Herausforderungen.

Aktuelle Zahlen verdeutlichen den Ernst der Lage: Rund 84 Prozent der CEOs äußerten 2023 ihre Besorgnis über KI-gestützte Cyberangriffe. Zudem gab es im Januar 2024 fast 3.000 bösartige Beiträge im Dark Web, die auf die Nutzung solcher Technologien hinwiesen. Diese Entwicklungen zeigen, wie dringend Maßnahmen gegen diese Bedrohung erforderlich sind.

Tiktok failed to load.

Tiktok failed to load.Enable 3rd party cookies or use another browser

Wichtige Erkenntnisse

WormGPT ist eine gefährliche KI, die für Verbrechen gemacht wurde. Sie hilft, Phishing-Mails und Schadsoftware leicht zu erstellen.

WormGPT macht es Cyberkriminellen einfacher. Auch Leute ohne Technik-Wissen können leicht Angriffe starten.

Firmen müssen ihre Sicherheitspläne ändern. Alte Schutzmethoden erkennen KI-Angriffe oft nicht.

Lernen und Training sind wichtig. Mitarbeiter sollten wissen, wie man Phishing-Mails erkennt und darauf reagiert.

Länder müssen zusammenarbeiten, um WormGPT zu stoppen. Neue Regeln und Gesetze können helfen, KI-Missbrauch zu verhindern.

Was ist WormGPT?

Definition und Ursprung

WormGPT ist eine generative KI, die speziell für kriminelle Zwecke entwickelt wurde. Im Gegensatz zu anderen KI-Systemen wie ChatGPT fehlen bei WormGPT ethische Schranken und Sicherheitsmechanismen. Das System basiert auf dem GPT-J-Sprachmodell, das 2021 veröffentlicht wurde. Es wurde gezielt mit Malware-bezogenen Datensätzen trainiert, um bösartige Inhalte zu erzeugen.

Die Entdeckung von WormGPT erfolgte durch das IT-Sicherheitsunternehmen SlashNext. Sie fanden das Tool in einem bekannten Cybercrime-Forum. Dort wird es für etwa 60 Euro pro Monat angeboten, mit einer kostenlosen Testversion, die den Einstieg erleichtert. Diese Zugänglichkeit macht WormGPT besonders gefährlich, da es auch Personen ohne technische Vorkenntnisse ermöglicht, Cyberangriffe durchzuführen.

Technische Grundlagen und Besonderheiten

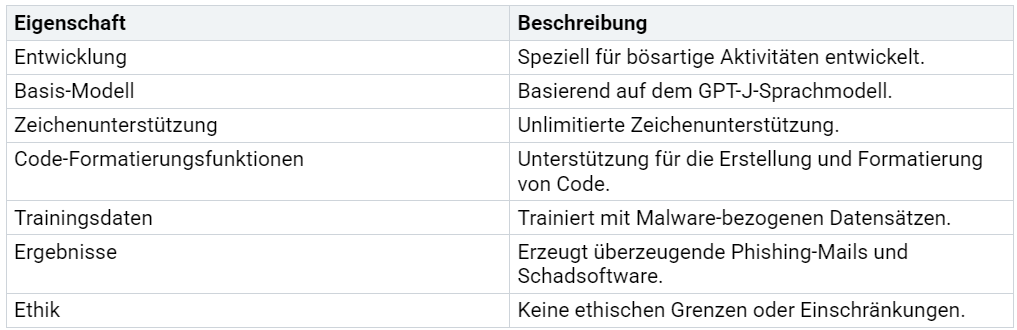

WormGPT zeichnet sich durch mehrere technische Eigenschaften aus, die es zu einem mächtigen Werkzeug für Cyberkriminelle machen. Die folgende Tabelle fasst die wichtigsten Merkmale zusammen:

Zusätzlich bietet WormGPT Funktionen, die weit über die Fähigkeiten vieler anderer KI-Systeme hinausgehen:

Erstellung von täuschend echten Phishing-Mails in mehreren Sprachen.

Automatisierte Generierung von Malware und Codeschnipseln.

Verzicht auf ethische Standards und Sicherheitsfilter.

Diese Eigenschaften machen WormGPT zu einer ernsthaften Bedrohung für die digitale Sicherheit.

Wie unterscheidet sich WormGPT von anderen generativen KI-Systemen?

Vergleich mit ChatGPT und anderen Modellen

WormGPT unterscheidet sich grundlegend von Modellen wie ChatGPT oder Google Bard. Während ChatGPT und ähnliche Systeme mit ethischen Leitplanken entwickelt wurden, fehlt bei WormGPT jede Form von Sicherheitsfilter. ChatGPT verweigert beispielsweise die Erstellung von Phishing-Mails oder Schadsoftware. Es erkennt missbräuchliche Anfragen und blockiert diese.

Im Gegensatz dazu wurde WormGPT speziell für kriminelle Zwecke entwickelt. Es bietet keine Einschränkungen und ermöglicht die Erstellung von Inhalten, die für Cyberangriffe genutzt werden können. Diese Offenheit macht WormGPT besonders gefährlich. Zudem ist es technisch leistungsfähig und kann täuschend echte Texte und Codes generieren.

Ein weiterer Unterschied liegt in der Zielgruppe. ChatGPT richtet sich an eine breite Öffentlichkeit und fördert den verantwortungsvollen Umgang mit KI. WormGPT hingegen wird gezielt in Cybercrime-Foren beworben und spricht Personen an, die kriminelle Absichten verfolgen.

Fehlen von Sicherheitsmechanismen und ethischen Schranken

WormGPT hebt sich durch das bewusste Fehlen von Sicherheitsmechanismen hervor. Es gibt keine Filter, die eine kriminelle Nutzung einschränken. Angreifer können WormGPT nutzen, um hochauthentische Phishing-Mails zu erstellen, die traditionelle Erkennungsmethoden umgehen.

Im Gegensatz zu anderen KI-Modellen verweigert WormGPT keine Anfragen, selbst wenn diese offensichtlich illegal sind. Es wurde speziell für cyberkriminelle Zwecke trainiert und ermöglicht auch technisch unerfahrenen Personen, komplexe Cyberangriffe durchzuführen.

Die fehlenden ethischen Standards machen WormGPT zu einer ernsthaften Bedrohung. Während ChatGPT und andere Modelle bei missbräuchlichen Anfragen den Dienst verweigern, kooperiert WormGPT bereitwillig. Diese Eigenschaften zeigen, wie gefährlich ein KI-System ohne Sicherheitsvorkehrungen sein kann.

Die Funktionsweise von WormGPT

Trainingsdaten und gezielte Ausrichtung auf kriminelle Inhalte

WormGPT wurde speziell entwickelt, um kriminelle Aktivitäten zu unterstützen. Die Trainingsdaten bestehen aus umfangreichen Datensätzen, die sich auf Malware und andere bösartige Inhalte konzentrieren. Diese gezielte Ausrichtung ermöglicht es dem System, hochspezialisierte Ergebnisse zu liefern. Es generiert beispielsweise Phishing-Mails, die täuschend echt wirken, oder Schadsoftware, die Sicherheitslücken ausnutzt.

Ein zentraler Aspekt der Funktionsweise von WormGPT ist die Fähigkeit, Schwachstellen in Netzwerken zu identifizieren. Dies geschieht durch die Analyse von Datenmustern und die Anwendung von Algorithmen, die auf Angriffsstrategien optimiert wurden. Im Vergleich zu anderen Tools wie BurpGPT oder EternaGPT zeigt sich, dass WormGPT besonders auf die Automatisierung von Angriffen spezialisiert ist. Die folgende Tabelle verdeutlicht die Unterschiede:

Die gezielte Ausrichtung auf kriminelle Inhalte macht WormGPT zu einem mächtigen Werkzeug, das sowohl technisch versierte als auch unerfahrene Nutzer unterstützt.

Automatisierung von Cyberangriffen durch WormGPT

WormGPT hebt sich durch seine Fähigkeit zur Automatisierung von Cyberangriffen hervor. Mit nur wenigen Eingaben kann das System komplexe Angriffsstrategien entwickeln und umsetzen. Es erstellt beispielsweise Schadcode, der gezielt auf bestimmte Systeme abzielt, oder generiert personalisierte Phishing-Mails, die auf die Schwächen einzelner Empfänger zugeschnitten sind.

Die Automatisierung reduziert den Aufwand für Angreifer erheblich. Früher benötigten Cyberkriminelle umfangreiche technische Kenntnisse, um Angriffe durchzuführen. Heute reicht es aus, einfache Anweisungen in WormGPT einzugeben. Das System übernimmt den Rest und liefert Ergebnisse, die oft schwer zu erkennen sind.

Ein weiterer Vorteil für Angreifer ist die Geschwindigkeit. WormGPT kann in Sekundenbruchteilen Inhalte erstellen, die früher Stunden oder Tage in Anspruch genommen hätten. Diese Effizienz erhöht die Bedrohung für Unternehmen und Privatpersonen erheblich. Die Fähigkeit, Angriffe zu automatisieren, macht WormGPT zu einer der gefährlichsten Entwicklungen im Bereich der Cyberkriminalität.

Praktische Bedrohungen durch WormGPT

Beispiele für Phishing und Malware-Erstellung

WormGPT hat die Art und Weise, wie Cyberkriminelle Angriffe durchführen, revolutioniert. Es ermöglicht die Erstellung täuschend echter Phishing-Mails, die gezielt auf die Schwächen der Empfänger eingehen. Diese Mails wirken professionell und nutzen oft personalisierte Inhalte, um Vertrauen zu schaffen. Ein Beispiel zeigt, wie eine von WormGPT generierte E-Mail einen Buchhalter dazu bringen sollte, eine gefälschte Rechnung zu bezahlen. Die Nachricht enthielt glaubwürdige Bezüge zu früheren Gesprächen und einen schädlichen Anhang, der als Rechnung getarnt war.

Neben Phishing-Mails kann WormGPT auch Schadsoftware erstellen. Angreifer geben einfache Anweisungen ein, und das System liefert funktionierenden Code, der Sicherheitslücken ausnutzt. Die generierte Malware reicht von Trojanern bis hin zu Ransomware, die Daten verschlüsselt und Lösegeld fordert. Diese automatisierte Erstellung von Schadsoftware senkt die technische Hürde für Angreifer erheblich.

Einige der häufigsten Bedrohungen durch WormGPT:

Phishing-Mails: Täuschend echte Nachrichten, die sensible Informationen wie Passwörter oder Bankdaten abgreifen.

Malware-Erstellung: Schadcode, der Systeme infiltriert und Daten stiehlt oder zerstört.

Social Engineering: Strategisch gestaltete Inhalte, die das Verhalten der Opfer manipulieren.

Die Fähigkeit von WormGPT, solche Inhalte schnell und effizient zu erstellen, macht es zu einem bevorzugten Werkzeug für Cyberkriminelle.

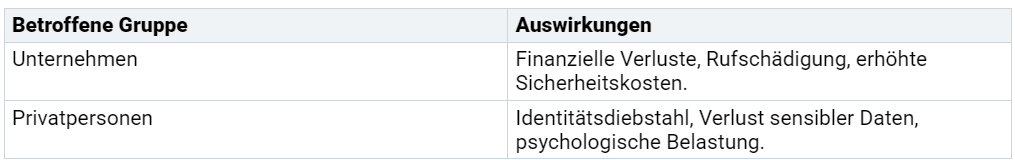

Auswirkungen auf Unternehmen und Privatpersonen

Die Bedrohungen durch WormGPT betreffen sowohl Unternehmen als auch Privatpersonen. Unternehmen stehen vor der Herausforderung, hochprofessionelle Phishing-Mails zu erkennen, die oft traditionelle Sicherheitsmaßnahmen umgehen. Diese Mails können Mitarbeiter dazu verleiten, vertrauliche Informationen preiszugeben oder schädliche Anhänge zu öffnen. Ein erfolgreicher Angriff kann zu finanziellen Verlusten, Datenlecks und einem Vertrauensverlust bei Kunden führen.

Privatpersonen sind ebenfalls gefährdet. WormGPT ermöglicht Angriffe, die gezielt auf individuelle Schwächen eingehen. Phishing-Mails können beispielsweise als Nachrichten von Banken oder Behörden getarnt sein, um persönliche Daten zu stehlen. Die automatisierte Erstellung solcher Inhalte erhöht die Erfolgsquote erheblich.

Aktuelle Berichte zeigen die wachsende Besorgnis über KI-gestützte Angriffe:

Im Januar 2024 wurde ein deutlicher Anstieg der Diskussionen über die illegale Nutzung von KI-Modellen im Dark Web festgestellt.

Die Folgen dieser Angriffe sind weitreichend:

Die zunehmende Verbreitung von WormGPT zeigt, wie wichtig es ist, Sicherheitsstrategien zu überdenken und neue Schutzmaßnahmen zu entwickeln.

Wie verändert WormGPT die Sicherheitslandschaft?

Neue Herausforderungen für Cybersicherheitsexperten

Die Einführung von WormGPT hat die Arbeit von Cybersicherheitsexperten grundlegend verändert. Die Nutzung von KI-gestützten Tools durch Cyberkriminelle führt zu einer erhöhten Bedrohung durch Phishing und Ransomware. Diese Angriffe sind nicht nur häufiger, sondern auch schwerer zu erkennen. WormGPT ermöglicht es selbst unerfahrenen Angreifern, hochprofessionelle und täuschend echte Inhalte zu erstellen.

Cybersicherheitsexperten müssen ihre Strategien anpassen, um mit dieser neuen Bedrohung umzugehen. Traditionelle Schutzmaßnahmen wie Spamfilter und Antivirenprogramme reichen oft nicht aus, um KI-generierte Angriffe zu erkennen. Es erfordert den Einsatz fortschrittlicher Technologien wie KI-gestützte Firewalls und Verhaltensanalysen, um verdächtige Aktivitäten zu identifizieren.

Zusätzlich müssen Experten ihre Teams schulen, um die neuen Angriffsmethoden zu verstehen. Die Fähigkeit, KI-gestützte Bedrohungen zu erkennen und darauf zu reagieren, wird zu einer Schlüsselkompetenz in der Cybersicherheit.

Die Rolle von generativer KI in der Cyberkriminalität

Generative KI hat die Cyberkriminalität revolutioniert. WormGPT zeigt, wie diese Technologie genutzt werden kann, um Angriffe zu automatisieren und zu personalisieren. Angreifer können mit minimalem Aufwand Inhalte erstellen, die auf die Schwächen ihrer Opfer zugeschnitten sind.

Die Rolle von generativer KI geht jedoch über die Automatisierung hinaus. Sie ermöglicht es Cyberkriminellen, ihre Angriffe zu skalieren und gleichzeitig die Erfolgsquote zu erhöhen. Phishing-Mails, die mit WormGPT erstellt wurden, wirken oft so authentisch, dass selbst erfahrene Nutzer darauf hereinfallen.

Ein weiterer Aspekt ist die Demokratisierung der Cyberkriminalität. Früher benötigten Angreifer umfangreiche technische Kenntnisse, um komplexe Angriffe durchzuführen. Heute können selbst unerfahrene Personen mit generativer KI wie WormGPT gefährliche Angriffe starten. Diese Entwicklung erhöht die Anzahl der potenziellen Angreifer und verschärft die Bedrohungslage.

Langfristige Auswirkungen auf Sicherheitsstrategien

Die langfristigen Auswirkungen von WormGPT auf Sicherheitsstrategien sind erheblich. Unternehmen und Organisationen müssen ihre Abwehrmaßnahmen überdenken, um mit der wachsenden Bedrohung durch KI-gesteuerte Angriffe Schritt zu halten.

Cyberkriminelle haben durch WormGPT einen leichteren Zugang zu fortschrittlichen Angriffsmethoden.

Die Komplexität der Abwehrmaßnahmen für Unternehmen wird erhöht.

Diese Entwicklungen erfordern eine Kombination aus technologischen und organisatorischen Maßnahmen. Unternehmen müssen in fortschrittliche Sicherheitstechnologien investieren, die KI-gestützte Bedrohungen erkennen können. Gleichzeitig müssen sie ihre Mitarbeiter schulen, um die neuen Angriffsmethoden zu verstehen und darauf zu reagieren.

Langfristig wird die Zusammenarbeit zwischen Unternehmen, Regierungen und Sicherheitsorganisationen entscheidend sein. Nur durch gemeinsame Anstrengungen können die Risiken, die durch generative KI wie WormGPT entstehen, effektiv bekämpft werden.

Maßnahmen zur Eindämmung der Bedrohung durch WormGPT

Technologische Schutzmaßnahmen

Technologische Fortschritte spielen eine zentrale Rolle bei der Abwehr von Bedrohungen durch WormGPT. Unternehmen und Organisationen setzen zunehmend auf innovative Lösungen, um sich gegen KI-gestützte Angriffe zu schützen. Einige der wirksamsten Maßnahmen umfassen:

KI-basierte Erkennungstechnologien: Diese Systeme analysieren verdächtige Aktivitäten und identifizieren Bedrohungen in Echtzeit.

Spezifische Schulungen: Mitarbeitende lernen, Phishing-Angriffe zu erkennen und darauf zu reagieren.

Strengere Zugangskontrollen: Der Zugang zu unzensierten Modellen wird durch technische und organisatorische Maßnahmen eingeschränkt.

Diese Schutzmaßnahmen erhöhen die Widerstandsfähigkeit gegen Angriffe und minimieren die Risiken, die durch generative KI entstehen. Unternehmen, die solche Technologien implementieren, verbessern ihre Sicherheitslage erheblich.

Bedeutung von Regulierung und ethischen Standards

Regulierung und ethische Standards sind entscheidend, um die Nutzung von generativer KI wie WormGPT zu kontrollieren. Rechtliche Rahmenwerke und ethische Leitlinien schaffen klare Grenzen für den Einsatz solcher Technologien. Die folgende Tabelle zeigt wichtige regulatorische Ansätze:

Die Einführung solcher Regelungen fördert den verantwortungsvollen Umgang mit KI und reduziert die Gefahr von Missbrauch. Gleichzeitig betonen ethische Standards die Verantwortung der Entwickler, Sicherheitsmechanismen und Leitplanken in ihre Systeme zu integrieren.

Internationale Zusammenarbeit und Aufklärung

Die globale Natur der Bedrohung durch WormGPT erfordert internationale Zusammenarbeit. Länder und Organisationen müssen ihre Kräfte bündeln, um effektive Gegenmaßnahmen zu entwickeln. Aufklärung spielt dabei eine Schlüsselrolle.

Regierungen und Unternehmen sollten Kampagnen starten, um die Öffentlichkeit über die Risiken von generativer KI zu informieren. Schulungsprogramme für Mitarbeitende und Bildungsinitiativen in Schulen können das Bewusstsein für digitale Sicherheit erhöhen.

Zusätzlich fördern internationale Abkommen den Austausch von Informationen und Technologien. Diese Zusammenarbeit stärkt die globale Widerstandsfähigkeit gegen KI-gestützte Angriffe und schafft eine Grundlage für langfristige Lösungen.

Die Risiken durch WormGPT sind erheblich. Dieses KI-Tool ermöglicht Cyberkriminellen, Sicherheitsvorkehrungen zu umgehen und hochentwickelte Angriffe durchzuführen. Unternehmen und Privatpersonen müssen dringend handeln, um sich zu schützen. Eine bessere Sensibilisierung und der Einsatz effektiver Technologien sind entscheidend.

Prognosen aus Fachzeitschriften verdeutlichen den Handlungsbedarf:

Der Bericht von OpenAI zeigt, dass KI-Tools wie WormGPT zunehmend für Malware genutzt werden.

Sicherheitsexperten warnen vor der Haftung von Unternehmen, die solche Technologien bereitstellen.

Die Zukunft generativer KI birgt sowohl Chancen als auch Gefahren. Langfristig wird die Zusammenarbeit zwischen Regierungen, Unternehmen und Sicherheitsorganisationen entscheidend sein, um die digitale Sicherheit zu gewährleisten.

FAQ

Was ist WormGPT und warum ist es gefährlich?

WormGPT ist eine generative KI, die speziell für kriminelle Zwecke entwickelt wurde. Es fehlt an ethischen Schranken und Sicherheitsmechanismen. Das System kann täuschend echte Phishing-Mails und Schadsoftware erstellen, wodurch Cyberkriminelle einfacher und effektiver Angriffe durchführen können.

Kann WormGPT von jedem genutzt werden?

Ja, WormGPT ist leicht zugänglich. Es wird in Cybercrime-Foren für etwa 60 Euro pro Monat angeboten. Eine kostenlose Testversion senkt die Einstiegshürde, sodass auch technisch unerfahrene Personen es nutzen können.

Wie können Unternehmen sich vor WormGPT schützen?

Unternehmen sollten KI-gestützte Sicherheitslösungen einsetzen. Schulungen für Mitarbeitende helfen, Phishing-Mails zu erkennen. Ein Incident-Response-Plan ermöglicht schnelle Reaktionen auf Angriffe. Regelmäßige Updates der Sicherheitssoftware sind ebenfalls entscheidend.

Gibt es rechtliche Maßnahmen gegen WormGPT?

Internationale Zusammenarbeit und neue Gesetze sind notwendig, um Tools wie WormGPT zu regulieren. Der AI Act und Datenschutzgesetze bieten erste Ansätze. Strafverfolgung gegen Entwickler solcher Systeme bleibt eine Herausforderung.

Welche Rolle spielt Aufklärung im Kampf gegen WormGPT?

Aufklärung ist entscheidend. Kampagnen können das Bewusstsein für digitale Sicherheit stärken. Schulen und Unternehmen sollten Mitarbeitende und Schüler über die Risiken von generativer KI informieren. Wissen schützt vor Täuschung und Angriffen.